BIOS Setup и разгонный потенциал

Достаточно богаты (особенно для плат от Intel) и настройки меню BIOS Setup D975XBX. Помимо типовых по конфигурированию периферии загрузки, power management и прочего здесь присутствует управление скоростью вращения двух вентиляторов (процессорного и системного) от температуры в нескольких зонах, мониторинг четырех вентиляторов, трех температур и пяти напряжений питания. Есть настройка четырех основных таймингов и частоты работы памяти в системе (причем возможна установка частоты 800 МГц для памяти при FSB 800 и 1067 МГц), а напряжение питания памяти можно поднимать до 2,2 В с шагом 0,1.

В отдельном пункте меню можно гибко разгонять систему - менять множитель процессора (если разблокирован) и напряжение его питания (от 1,275 до 1,600 В), независимо поднимать (или опускать) частоту FSB (базовые уровни - 533, 800, 1067 или 1333 МГц), шин PCI Express (100-110 МГц) и PCI (до 40 МГц), повышать напряжение питания северного моста чипсета (от 1,5 до 1,73 В) и системной шины (от 1,25 до 1,4 В).

Плата Intel разгоняется по частоте до 30% с шагом 1% через пункт Host Burn-In Mode Percentage в меню BIOS Setup. На практике с двухъядерным процессором Intel Pentium Extreme Edition 955 на новом 65-нм ядре Presler (со штатной системной шиной 1067 МГц) мне без труда удалось разогнать плату Intel D975XBX на 25% по FSB при штатном напряжении питания (FSB составила 1333 МГц), а с небольшим поднятием напряжения на шине FSB и северном мосте - и на все "дозволенные БИОСом" 30%, то есть до FSB=1382 МГц. К сожалению, настройка FSB=1333 МГц в пункте меню FSB Frequency Override на практике не заработала. И тем не менее плата Intel D975XBX продемонстрировала отличный разгонный потенциал - на уровне лучших продуктов ведущих тайваньских производителей.

За предоставленное оборудование редакция журнала "Экспресс-Электроника" благодарит представительство компании Intel.

Чипсет Intel 975X Express

Выпущенный Intel осенью 2005-го, этот чипсет, является по сути уже известным нам с весны того же года набором Intel 955X Express, в котором "узаконили" использование графической шины PCI Express x16 для подключения двух видеокарт, работающих в паре (Nvidia SLI и ATI CrossFire, правда, только при наличии поддержки со стороны драйверов от ATI и Nvidia). Причем на каждую карту электрически выделяется шина PCI Express x8.

Напомним, на момент выхода i955X у Intel тоже была плата (D955XBK) с двумя слотами PCI Express x16 для работы с парой видеокарт. Похожие платы на чипсетах Intel 955X и 945P имелись и у ведущих тайваньских производителей. Однако из-за "детских болезней" полноценную поддержку "парных" технологий Nvidia и ATI так и не удалось реализовать. i975X Express и призван исправить наконец этот недочет и стать полноценным конкурентом чипсету Nvidia nForce4 SLI (Intel Edition), фактически господствовавшему более полугода в нише сертифицированных "парных" графических платформ.

В остальном параметры чипсета Intel 975X Express полностью повторяют характеристики своего предшественника, поэтому углубляться в подробности не станем.

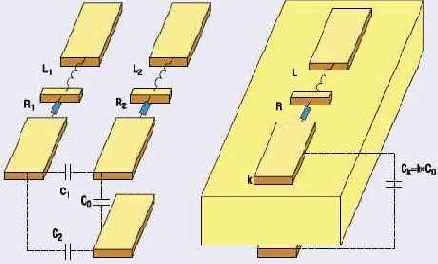

Диаграмма.Архитектура чипсета Intel 975X Express

Помимо "графической", у чипсета i975X есть еще одна цель - послужить "правильной" платформой выходящим в начале 2006 года процессорам Intel Pentium D на новых 65-нм ядрах Presler и CedarMill. Несмотря на техническую совместимость с прежними чипсетами серий 955/945 Express, процессоры на новых ядрах могут оказаться несовместимыми с некоторыми не очень дальновидно спроектированными материнскими платами на этих чипсетах, что было бы особенно обидно (когда речь идет о продуктах для высокопроизводительных платформ). К тому же i975X готовит почву для будущих процессоров Intel - в частности, имеет полуофициальную поддержку системной шины 1333 МГц и памяти DDR2-800. Кстати, еще одним отличием i975X является изначальная поддержка процессоров с Intel VT (Virtualization Technology), а также полезной технологии Intel Active Management.

Да и с мостом ICH7R чипсет получает возможность использовать до шести линий PCI Express x1 (вместо четырех у ICH7 и ICH6/6R). По сравнению с чипсетом Nvidia nForce4 SLI Intel Edition новый продукт Intel никаких заметных преимуществ не предоставляет и даже наоборот - у nForce4 вдвое больше объем поддерживаемой памяти, быстрее шина связи между мостами, шины PCI Express x1 обеспечиваются северным мостом (а не южным, как у Intel), южный мост Nvidia MCP04 имеет два порта UltraATA/133 (а не один UltraATA/100, подобно Intel), которые также можно задействовать для создания RAID-массивов, 10 вместо восьми портов USB 2.0 и, наконец, у чипсета Nvidia есть встроенный гигабитный сетевой контроллер с мощным брандмауэром ActiveArmor. Хотя, если сравнивать с nForce4 SLI IE, то среди достоинств i975X Express присутствует возможность организовать до шести линий PCI Express x1 (вместо четырех у Nvidia), более качественный аудиоконтроллер Intel High Definition Audio и технология Intel Matrix Storage, благодаря которой всего на паре SATA-дисков можно одновременно организовать массивы RAID 0 и RAID 1.

Intel D975XBX: i975X Express "глазами" разработчика

Алекс Карабуто

"Экспресс-электроника"

Признаться, писать статьи о материнских платах - занятие неблагодарное. Ведь большинство плат одного класса похожи друг на друга, как две капли воды. Иное дело, если выходит плата на очередном чипсете, тогда обзор в какой-то степени превращается в рассказ о возможностях нового набора системной логики.

Cегодня именно такой случай - топовая плата от Intel на новом чипсете. Плата Intel D975XBX и чипсет Intel 975X Express предназначены для самого верхнего сегмента рынка настольных ПК, а также для рабочих станций начального и среднего уровней, поскольку предназначены для двухъядерных процессоров, что вкупе с технологией HT образует до четырех логических процессоров в одной системе. Более того, чипсет и плата позволяют установить до двух мощных графических карт для шины PCI Express, и на такую же шину можно "усадить" еще и профессиональный RAID-контроллер, создав высокопроизводительную и надежную дисковую подсистему. То есть, несмотря на свою "однопроцессорность" (заявленную на уровне чипсета i975X), данная платформа отлично подойдет и для мощных графических рабочих станций, а не только топовых ПК.

Плата Intel D975XBX

Эта системная плата, безусловно, возглавляет существующий перечень плат Intel для настольных ПК и графических рабочих станций начального уровня. Среди привлекательных новшеств, которые и делают эту плату очень удобной для создания высокопроизводительных систем, стоит отметить сразу три (!) механических слота PCI Express x16. На первый из них разведены все 16 линий графической шины PCI Express x16, на второй - восемь линий этой же шины, автоматически отключающиеся от первого слота, если используются две видеокарты (что гораздо удобнее, нежели в платах на nForce4 SLI с механическим "слотом-переключателем"). Наконец, на третий слот PCI Express, расположенный между двумя слотами PCI32, заведено четыре линии PCI Express x1 от моста ICH7R. То есть данный слот с пиковым пропусканием шины до 1 Гбайт/с в обоих направлениях может использоваться для установки высокопроизводительных RAID-контроллеров Serial ATA или Serial Attached SCSI (они, как правило, имеют шину PCI Express x4 или x8), или для иной нужной периферии, включая карты PCI Express x1.

Впрочем, практически вся необходимая периферия уже предусмотрена на плате. Помимо высококлассного звука (8-канальный Intel High Definition Audio, аудиокодек SigmaTel 9221, шум - менее 90 дБ), восьми штатных портов USB 2.0, богатых Serial ATA RAID-возможностей моста ICH7R (четыре порта по 3 Гбит/с, NCQ, HotPlug, RAID 5, 10 и пр.) на плате присутствуют и дополнительные контроллеры. Так, на шине PCI установлен двухпортовый контроллер интерфейса IEEE 1394a (FireWire 400 Мбит/с), рядом есть еще один четырехпортовый SerialATA RAID SiI3114 от Silicon Image (RAID 0, 1, 10; в бета-версии возможен и программный RAID 5), а к оставшимся линиям PCI Express x1 подключен гигабитный Ethernet-контроллер Intel 82573. Все шины PCI Express и PCI оснащены также шиной SMBus. На плате имеется чип аппаратного мониторинга и коннекторы для подключения четырех вентиляторов (процессорный и Aux обеспечивают ток до 3 А, два других - до 1,5 А).

Плату выгодно отличает использование бесшумного пассивного охлаждения (радиаторы без вентиляторов на обоих мостах чипсета, а также на силовых ключах стабилизатора питания процессора; в работе все они едва теплые), импульсного стабилизатора напряжения на памяти и мощного пятифазного (судя по количеству катушек и блоков ключей) стабилизатора напряжения питания процессора.

За это, кстати, приходится "платить" необходимостью использования 8-контактного "серверного" разъема питания + 12 В. На задней панели платы помимо прочего присутствуют оптический и коаксиальный S/PDIF-выходы. Разъемы Serial ATA имеют обойму, защищающую от случайного излома. Из недостатков платы (и в качестве пожеланий на будущее) отметим использование низкоскоростного IEEE 1394a вместо вдвое более быстрого наследника 1394b, а также применение устаревшего PCI-контроллера SATA 1.0 SiI3114, тогда как уже более года назад выпущен его наследник SiI3124 с поддержкой SATA 2.5 (3 Гбит/с и NCQ). Кроме того, можно было бы использовать и SATA2-контроллер SiI3132 и вывести один-два SATA-порта на заднюю панель платы. Не помешал еще хотя бы один UATA-порт.

| Плюсы: |

| Отличный разгонный потенциал Бесшумное пассивное охлаждение Три механических слота PCI Express x16 |

| Минусы: |

| Использование низкоскоростного IEEE 1394a Устаревший PCI-контроллер SATA 1.0 SiI3114 |

Что мы уже знаем...

Для тех, кто не читал публикаций о новых чипсетах Alderwood, и Grantsdale, а также для всех остальных, кто успел подзабыть то, что читал когда-то, напомним, чем интересны новые чипсеты и чем они отличаются от старых.

Перечисляя все это, нельзя удержаться и не вспомнить о «цифровом доме» - концепции,которую так активно продвигает Intel. Действительно, настольный компьютер с такими характеристиками стоит считать полноценным медиацентром. Однако вернемся к вопросу производительности. Что же несет переход на более высокие частоты шины как процессорной, так и DMI (Direct Media Interface), соединяющей южный и северный мосты? К чему приводит использование DDR2? На эти вопросы поможет ответить только эксперимент.

Что тестируем?

Для начала давайте разберемся, что и с чем мы хотим сравнить? Во-первых, нас интересует, как будут работать новые процессоры на новой платформе и как поведут себя «старые» модели. Во-вторых, хотелось бы сравнить данные результаты с тем, что удалось сделать конкуренту — поэтому в тесте фигурируют платформы AMD. Ну и наконец, любопытно, как поведет себя память DDR2 с большей пропускной способностью, но и большими задержками. Итак, имеем семь тестовых стендов по одному для каждого из процессоров:

Intel Pentium 4 560 (LGA775); Intel Pentium 4 550 (LGA775); Intel Pentium 4 Extreme Edition 3,4 ГГц (LGA775); AMD Athlon 64 FX-53 (Socket 939); AMD Athlon 64 3700+ (Socket 754); Intel Pentium 4 3.4E ГГц (Socket 478, Prescott); Intel Pentium 4 Extreme Edition 3.4 ГГц (Socket 478).

Южный мост ICH6RW

Процессоры AMD работали на платах ASUS A8V Deluxe (Socket 939, VIA K8T800 Pro) и ABIT KV8-MAX3 (Socket 754, VIA K8T800), которые отличаются главным образом тем, что на A8V реализована двухканальная память DDR400, а на KV8-MAX3 — нет. Что касается решений Intel, старшие модели работали на Intel D925XCV

Разъем Socket 775 реализует новый метод крепления процессора

(LGA775, i925X Express), а младшие модели - на ASUS P4C800-E Deluxe (Socket 478, i875P). Первая плата работает с DDR2, а вторая — с DDR SDRAM.

Intel 9xx: время тестов

Андрей Шуклин

Журнал "Экспресс электроника 09`04"

Громкий анонс новых платформ от компании Intel уже прошел, и сегодня мы можем оценить их реальную производительность. Что несут новые платы пользователю? Получит ли он реальный прирост мощности? Давайте попробуем в этом разобраться. Вообще, вопрос производительности вызывает отнюдь не праздный интерес: то, что новые платформы окажутся привлекательными с точки зрения возможностей, сомнений уже не вызывает. Реализация более качественного аудио, возможностей RAID и других функций, конечно, привлекает пользователя, но ведь всегда хочется знать, будет ли на новой платформе быстрее работать офисный пакет, удастся ли тратить меньше времени на архивацию и немного повысить уровень детализации в любимой игре?

Тесты

Первый тест — новый офисный пакет SysMark 2004. Он включает несколько отдельных категорий, в числе которых 3D Creation, 2D Creation, Web Publication, Communication, Document Creation и Data Analysis. В 3D Creation происходит рендеринг изображения и построение векторной анимации, а также создание веб-публикаций в Dreamweaver MX. Что касается 2D Creation, в данном случае моделируется работа пользователя в Premiere 6.5, который создает видеоролик из нескольких других роликов в сыром формате и отдельных звуковых треков. В тесте также используется Photoshop 7.01 и After Effects 5.5. Далее, Web Publication: тест на работу Flash MX, Windows Media Encoder 9 и VirusScan 7.0. В секции Communication происходит работа Internet Explorer 6.0 и Outlook 2002 с проверкой системы утилитой VirusScan 7.0. Название Document Creation говорит само за себя: скрипт редактирует текст в Word 2002, а также использует Dragon NaturallySpeaking 6 для преобразования аудиофайла в текстовый документ. После этого — преобразование в PDF при помощи Acrobat 5.0.5. и создание презентации в PowerPoint 2002. И наконец, Data Analysis — работа с базой данных в Access 2002 и таблицей Excel при попутном архивировании WinZip 8.1.

Вот такой тест. Пожалуй, он наиболее полно представляет все возможные сферы деятельности пользователя офисного компьютера (см. таблицу 1).

Таблица 1. Результаты теста SysMark 2004, баллы

Как видно, новые процессоры даже немного отстают от старых. Скорее всего, это объясняется большими задержками памяти DDR2, что мы и проверим в следующем тесте. Изделия компании AMD немного отстают, что можно объяснить отсутствием технологий, аналогичных Hyper-Threading. Надо сказать, в офисном тесте она очень полезна, поскольку симулятор запускает многие приложения параллельно.

Второй тест — SiSoft Sandra 2004, с помощью которой мы напрямую оценим возможности памяти DDR2 по сравнению с DDR400 (таблица 2). Итак, результаты этого теста показывают некоторую «заторможенность» памяти DDR2. То есть даже при большем значении пиковой пропускной способности память DDR2 533 МГц отстает от DDR400.

Вообще говоря, разрыв не так и велик, но все же определенное падение производительности подсистемы памяти налицо. Скорее всего, преимущества памяти DDR2 пока еще не слишком востребованы приложениями и, как следствие, не вполне реализованы алгоритмы, способные эффективно использовать DDR2.

Таблица 2. Результаты теста SiSoft Sandra 2004, баллы

Теперь оценим работу платформ при кодировании медиаданных с помощью DivX 5.1.1 в XMpeg 5.0 (таблица 3). Как вы можете видеть, особого прироста не наблюдается, даже наоборот - новые платформы работают чуть медленнее, но не настолько, чтобы это было действительно ощутимо. Похоже, с точки зрения вычислительной мощности новая платформа не выигрывает и не проигрывает старой.

Таблица З. Кодирование в DivX5.11,fps

И последний тест — игровой. Его сложность состоит в том, что платформы обладают различными шинами для видеоускорителя - PCI Express x16 и AGP x8. Чтобы выйти из положения, мы взяли две видеокарты на одинаковом ядре — NVIDIA GeForce FX 5900XT и NVIDIA GeForce PCX 5900, а также использовали показатели вклада процессора в рендеринг сцен (таблицы 4 и 5). Из этого видно, что переход на новую платформу также ничего не дает по части производительности. Впрочем, ничего иного и не приходилось ожидать.

Таблица 4. Результаты теста ЗВМагк 2003 SE (процессор), баллы

Таблица 5. Результаты теста ЗВМагк2003 SE, общий балл

Как мы могли убедиться, новая

Как мы могли убедиться, новая платформа хороша как концепт. Она, можно сказать, сделана навырост — это и DDR2, и PCI Express, и SATA RAID. Да, новинка хороша инфраструктурой, однако в производительности мы, увы, не выигрываем. К тому же на сегодняшних приложениях память DDR2 оказывается не столь эффективной, как DDR400. Таким образом, новый продукт порадует тех, кому нужен более функциональный компьютер, а не более производительный процессор.

Анализ результатов

В заключение попробуем проанализировать результаты тестирования.

Бенчмарки

С учётом позиционирования двухъядерных процессоров как процессоров для работы с 3D-графикой и обработки видео- и аудиоданных, а также для работы в многопоточной среде, для их сравнительного тестирования были отобраны тесты и приложения, направленные на обработку звуковых и видеофайлов, созданий Интернет-контента, а также стандартные офисные приложения. Использовались следующие тестовые пакеты и приложения:

офисные тесты: - VeriTest Business Winstone 2004,

- VeriTest Multimedia Content Creation Winstone 2004,

OCR-распознавание: - ABBYY FineReader 8.0 (распознавание pdf-документа);

Архивирование: - WinRAR 3.00 (архивирование файлов)

3D-приложения: - Discreet 3d Studio Max 7.0 (рендеринг 3D-сцен),

Обработка видео- и аудиоданных: - Lame 4.0 alpha 14 (конвертирование формата wav в mp3),

- iTunes 5.0.01.4 (конвертирование формата wav в mp3),

- MP3Gain v.1.2.5 (обработка mp3-файла),

- XMPEG 5.2+DivX 6.0 (конвертирование формата MPEG-2 в DivX),

- TMPGEnc 2.5.24 (конвертирование avi-файла в формат m2v),

- Windows Media Encoder 9.0 (конвертирование avi-файла в формат wmv),

- Adobe After Effects 6.5.

Двухъядерные процессоры Intel: выбираем лучший

Василий Леонов

Тестовая лаборатория Ferra

Выражаем благодарность компании ASBIS за предоставленные для обзора процессоры.

В апреле 2005 года корпорация Intel объявила о выходе двухъядерной платформы, включающей семейство двухъядерных процессоров Intel Pentium D 8xx и набор микросхем Intel 955X Express. На сегодняшний день в модельном ряде двухъядерных процессоров Intel для ПК насчитывается четыре модели, которые отличаются друг от друга тактовой частотой, набором поддерживаемых технологий и, конечно же, стоимостью. В этой статье мы сравним производительность всех двухъядерных процессоров Intel и выберем самый оптимальный по соотношению цена/производительность процессор.

Методика тестирования

Для тестирования процессоров семейства Intel Pentium D и Intel Pentium Processor Extreme Edition 840 использовалась абсолютно одинаковая конфигурация стенда, то есть одними и теми же были системная плата, память, дисковая подсистема, видеокарта и т.д. Стенд для тестирования имел следующую конфигурацию: материнская плата: Gigabyte 8I955X Royal (версия BIOS F7); чипсет материнской платы: Intel 955X Express (ICH7); память: Corsair 2 x 512 Мбайт DDR2-667 (PC5300); видеокарта: ATI RADEON X700 XT (256 Мбайт) (интерфейс PCI Express x16); дисковая подсистема: Seagate Barracuda ST3160827AS (ёмкость 160 Гбайт); файловая система: NTFS с размером кластера по умолчанию (4 Кбайт).

В качестве операционной системы использоваласьОС WindowsXP Professional (English) c SP2.

Из дополнительных утилит и драйверов применялись: Intel Chipset Software Utility Version 7.0.0.1019; версия видеодрайвера: ATI 6.14.10.6497.

Все тесты производились при глубине цвета 32 бит и частоте строчной развертки 60 Гц.

Многоядерность — следующий этап развития

Избежать конфликтных ситуаций, возникающих при использовании технологии Hyper-Threading, можно в том случае, если изолировать в пределах одного процессора выполнение различных потоков инструкций. Фактически для этого потребуется использовать не одно, а два и более ядер процессора. Тогда в идеальном варианте каждый поток инструкций утилизирует отведённое ему ядро процессора (и исполнительные блоки), что позволяет избежать конфликтных ситуаций и увеличить производительность процессора за счёт параллельного выполнения потоков инструкций.

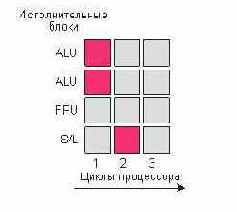

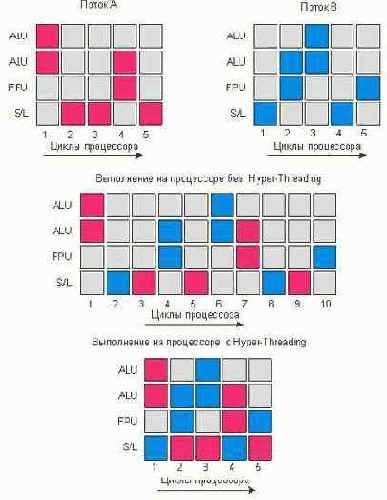

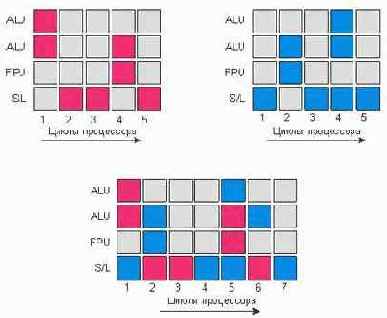

В рассмотренном примере возникновения конфликтных ситуаций при использовании технологии Hyper-Threading применение двух независимых ядер для выполнения двух потоков инструкций позволило бы выполнить весь программный код не за семь (как в случае процессора с технологией Hyper-Threading), а за пять тактов (рис. 4).

Рисунок 4. Преимущество двухъядерной архитектуры процессора

Конечно, говорить о том, что двухъядерные процессоры в два раза производительнее одноядерных, не приходится. Причина заключается в том, что для реализации параллельного выполнения двух потоков необходимо, чтобы эти потоки были полностью или частично независимы друг от друга, а кроме того, чтобы операционная система и само приложение поддерживали на программном уровне возможность распараллеливания задач. И в связи с этим стоит подчеркнуть, что сегодня далеко не все приложения удовлетворяют этим требованиям и потому не смогут получить выигрыша от использования двухъядерных процессоров. Пройдет ещё немало времени до тех пор, пока написание параллельного кода приложений ни войдет в привычку у программистов, однако первый и самый важный камень в фундамент параллельных вычислений уже заложен. Впрочем, уже сегодня существует немало приложений, которые оптимизированы для выполнения в многопроцессорной среде, и такие приложения, несомненно, позволят использовать преимущества двухъядерного процессора. Кроме того, двухъядерная архитектура процессора позволяет выявить преимущества при одновременной работе с несколькими приложениями, что является типичной ситуацией на сегодняшний день.

Модельный ряд двухъядерных процессоров Intel

Модельный ряд двухъядерных процессоров Intel на сегодняшний день включает в себя 4 модели: процессор Intel Pentium Processor Extreme Edition 840 и три процессора семейства Intel Pentium D.

Процессор Intel Pentium Processor Extreme Edition 840 – флагман линейки десктопных двухъядерных процессоров Intel. Итак, процессор Intel Pentium Extreme Edition 840 – это процессор с двумя ядрами на одном кристалле и корпусировкой LGA775. Тактовая частота процессора составляет 3,2 Ггц.

Каждое ядро процессора имеет микроархитектуру NetBurst. Отметим, что среди семейства всех двухъядерных процессоров Intel процессор Intel Pentium Processor Extreme Edition 840 – единственный, который поддерживает технологию Hyper-Threading, что в совокупности обеспечивает обработку до четырёх потоков. Поэтому один такой физический процессор с точки зрения операционной системы определяется как четыре логических процессора.

Каждое ядро процессора имеет собственный кэш второго уровня L2 объёмом 1 Мбайт, соответственно, общий объём кэша L2 составляет 2 Мбайта. Процессор производится по 90-нанометровому технологическому процессу, при этом размер самого кристалла процессора составляет 206 мм2, а количество транзисторов внутри процессора – 230 млн. Казалось бы, такой мощный двухядерный процессор будет выделять чрезмерно много тепла и потребует эффективной системы охлаждения. Однако, процессор Intel Pentium Extreme Edition 840 поглощает всего 130 Вт, а максимальная температура поверхности кристалла не превосходит 70 градусов Цельсия. Напряжение питания ядра процессора составляет от 1,25 В до 1,388 В, а максимальный ток – 125 А

Кроме того, отметим, что данный процессор поддерживает технологии Intel Extended Memory 64 Technology, Execute Disable Bit, а также технологии тепловой защиты Thermal Monitor и Thermal Monitor 2. В то же время, данный процессор не поддерживает технологию энергосбережения Enhanced Intel SpeedStep.

Данный процессор ориентирован на использование в компьютерах и рабочих станциях, критичных к ресурсоёмким приложениям с многопоточной обработкой данных.

Настройки тестов

Первые два теста — традиционные бенчмарки, предназначенные для тестирования производительности системы в целом c использованием популярных офисных приложений. Результаты этих тестов определяются не только процессором, но и пропускной способностью памяти, а также производительностью дисковой подсистемы компьютера. При использовании данных тестов устанавливалось разрешение экрана 1024 х 768 точек при 32-битной глубине цвета.

Приложение ABBYY FineReader 8.0 использовалось для распознавания многостраничного pdf-документа, в процессе которого измерялось время выполнения задачи. Данный тест является многопоточным и оптимизирован под двухъядерные процессоры.

В тесте WinRAR 3.0 использовалась максимальная степень сжатия с размером словаря 4096 Кбайт. При этом отметим, что сам по себе тест является однопоточным, поэтому ожидать, что двухъядерные процессоры получат в этом тесте преимущество, не приходится.

Ещё одна группа тестов была ориентирована на измерение производительности процессора при обработке аудио- и видеоданных. Для конвертации аудиоданных из формата wav в формат mp3 использовались кодеки Lame 4.0 alpha 14 и iTunes 5.0.0.1.4. Кроме того, для обработки mp3-файла использовалась утилита MP3Gain v.1.2.5.

Отметим, что кодек iTunes 5.0.1.4 эффективно раскладывает аудиоданные на два потока и использует два ядра процессора. В то же время, использование технологии Hyper-Threading в процессоре серии Extreme Edition не приводит к распараллеливанию потока на четыре логических ядра процессора.

Отметим, что при конвертировании аудиофайла с использованием кодека iTunes 5.0.1.4 использовался файл размером 701,5 Мбайт (1411 kbps, 44 кГц, Stereo, 16 бит), а битрейт составлял 160 kbps.

При использовании для конвертирования кодека Lame 4.0 alpha 14 использовался тот же самый wav-файл, причём запуск процесса конвертирования производился из командной строки. При этом использовалась команда запуска с параметром -nores (команда c:\lame.exe –nores –mt mixTest.wav), что позволяет задействовать два ядра процессора.

В кодеке Lame 4. 0 alpha 14 скорость потока составляла 128 kbps, а скорость сэмплирования – 44 кГц. Для конвертирования видеофайла из формата MPEG-2 (расширение файла mpg) в формат DivX (контейнер avi) использовалась утилита XMPEG 5.2 с кодеком DivX 6.0. Размер исходного видеофайлафайла (в формате MPEG-2) составлял 110 Мбайт (разрешение 720 х 480), а размер сжатого файла в формате DivX – 88,8 Мбайт. При этом звук не подлежал компрессии (48 кГц, Stereo, 128 kbps), а скорость видеопотока составляла 6147 kbps. Отметим, что утилита XMPEG 5.2 с использованием кодека DivX 6.0 прекрасно раскладывает поток данных на два ядра процессора, равномерно загружая их. В то же время, разложение на четыре потока (с учётом технологии Hyper-Threading) малоэффективно. Для конвертирования avi-видеофайла в формат m2v использовалась утилита TMPGEnc 2.5.24. При этом устанавливались настройки DVD NTSC (4:3, 525 lines) (MPEG-2, 720x480, битрейт 7995 kbps). В итоге исходный видеофайл, который был создан кодеком DivX MPEG-4 Low Motion, с размером 51,9 Мбайт конвертировался в m2v файл размером 222 Мбайт и wav-файл размером 42,7 Мбайт. Отметим, что процесс конвертирования с помощью утилиты TMPGEnc 2.5.24 оптимизирован под двухъядерные процессоры. В процессе конвертирования в равной степени загружаются оба ядра процессора. Добавление технологии Hyper-Threading к каждому ядру процессора не способствует росту эффективности конвертирования. Для конвертирования того же avi-файла (кодек DivX MPEG-4 Low Motion) в формат wmv использовались программы Windows Media Encoder 9.0 (Advanced Profile). При использовании конвертора Windows Media Encoder 9.0 (Advanced Profile) размер результирующего файла составлял 7,82 Мбайт. Следующий тест – это популярное 3D-приложение Discreet 3d Studio Max 7.0, которое использовалось только для рендеринга трёхмерных сцен, поскольку именно в этом режиме на центральный процессор системы ложится наибольшая нагрузка. Во всех тестах, кроме пакта VeriTest Business Winstone 2004 и VeriTest Multimedia Content Creation Winstone 2004, измеряемой характеристикой являлось время выполнения задачи.

Поэтому чем меньше оказывалось время, то есть результат теста, тем лучше. Кроме того, для того, чтобы оценить преимущества двухъядерных процессоров при многопоточной обработке данных одновременно комбинировалось несколько тестов, запускавшихся одновременно. Так, процесс конвертирования формата wav в mp3 кодеком lame 4.0 мы сочетали с одновременной обработкой mp3-файла утилитой MP3Gain v.1.2.5. Для этого сначала запускался более длительный процесс конвертирования, и на фоне выполнения этой задачи запускалась более короткая задача обработки mp3-файла. В этом случае время выполнения задачи рассчитывалось как время выполнения более короткой задачи, то есть обработки mp3-файла. Аналогично процесс конвертирования одного видеофайла из формата mpg в DivX (XMPEG 5.2с кодеком DivX 6.0) сочетался с процессом конвертирования другого видеофайла из формата DivX в формат wmv (Windows Media Encoder 9.0). В этом случае фоновым процессом являлся более длительный процесс конвертирования DivX в wmv, а за результат теста принималось время конвертирования формата mpg в формат DivX. Результаты сравнительного тестирования процессоров представлены в таблице.

| Тесты | Intel Pentium Extreme Edition 840 | Intel Pentium D 840 | Intel Pentium D 830 | Intel Pentium D 820 |

| Business Winstone | 22.56±0.21 | 22.64±0.21 | 22.08±0.32 | 21.06±0.14 |

| Mulitasking Test | 2.81±0.02 | 2.95±0.10 | 2.89±0.09 | 2.80±0.07 |

| Multimedia Content Creation | 31.90±0.09 | 31.92±0.10 | 30.38±0.06 | 28.58±0.14 |

| iTunes 5.0.01.4 (wav->mp3) | 133.60±7.38 | 119.50±0.51 | 126.40±0.68 | 134.60±0.68 |

| lame 4.0 a14 (wav->mp3) 128 kbps | 163.40±1.11 | 164.00±1.52 | 174.60±0.68 | 187.00±0.00 |

| MP3Gain v.1.2.5 | 72.20±0.56 | 71.80±0.56 | 77.00±0.88 | 83.00±0.88 |

| WinRAR 3.0 | 162.40±6.51 | 165.60±1.11 | 170.60±1.42 | 175.60±1.88 |

| WinRAR 3.0 (два потока) | 226.20±11.3 | 210.20±4.16 | 213.60±0.68 | 217.40±1.42 |

| TMPGEnc 2.5.24 (avi -> m2v) | 238.86±6.68 | 221.20±1.36 | 233.80±2.54 | 250.40±1.88 |

| XMPEG 5.2 (кодек DivX 6.0) (MPEG-2->DivX) | 140.60±1.42 | 137.80±2.39 | 146.00±1.96 | 155.00±1.52 |

| Windows Media Encoder 9 (avi -> wmv) | 122.20±1.04 | 142.80±2.54 | 153.20±1.84 | 160.60±1.42 |

| Adobe After Effects 6.5, с | 417.60±4.35 | 414.00±1.76 | 436.60±1.88 | 464.20±2.04 |

| ABBYY FineReader 8.0, с | 111.00±1.52 | 110.80±1.04 | 117.00±1.52 | 125.80±1.04 |

| 3d Studio Max 7.0 Rendering | 250.59±1.27 | 301.08±0.61 | 320.60±0.54 | 343.26±0.58 |

Все тесты запускались как минимум по пять раз. Для некоторых тестов число прогонов увеличивалось до десяти раз, что позволило обеспечить требуемую точность измерения. В качестве результата тестирования использовалось среднее по выборке от всех прогонов, то есть:

Обработка аудиоданных

Теперь обратимся к результатам тестирования процессоров в задачах по обработке аудиоданных. При использовании популярной утилиты iTunes 5.0.01.4 для конвертирования аудиофайла в формате wav в формат mp3 время конвертирования линейно уменьшается с ростом тактовой частоты процессора, что вполне естественно. Напомним, что при конвертировании с помощью утилиты iTunes 5.0.01.4 загружаются оба ядра процессора, то есть приложения оптимизированы под двухъядерную архитектуру. В то же время, технология Hyper-Threading в процессоре Intel Pentium Processor Extreme Edition 840 сводит на нет всё его преимущество по тактовой частоте, опуская его до уровня процессора Intel Pentium D 820. Ну что ж, к вредоносным последствиям Hyper-Threading в двухъядерных процессорах мы начинаем уже потихоньку привыкать.

Использование для конвертирования аудиофайлов популярного кодека Lame 4.0 приводит примерно к таким же результатам: наблюдается уменьшение времени конвертирования по мере роста тактовой частоты. Однако в данном случае последствия от активирования технологии Hyper-Threading не так катастрофичны. Если она и не способствует уменьшению времени конвертирования, так хоть не увеличивает его. При использовании утилиты MP3Gain v. 1.2.5 для обработки mp3-файлов наблюдаются аналогичные результаты: вреда от технологии Hyper-Threading нет (пользы, правда, тоже), а лидером в данном случае является процессор с более высокой тактовой частотой.

Рисунок 8. Результаты тестирования процессоров в задачах по обработке аудиофайлов

Обработка видеоданных

Теперь обратимся к рассмотрению результатов тестирования процессоров в задачах по обработке видеофайлов.

При использовании утилиты XMPEG 5.2 с кодеком DivX 6.0 для конвертирования видеофайла из формата MPEG-2 в DivX наилучшие результаты демонстрирует процессор Intel Pentium D 840. Технология Hyper-Threading в процессоре Intel Pentium Processor Extreme Edition 840 в данном случае не позволяет получить прироста производительности (более того, результаты при этом становятся немного хуже).

Примерно аналогичный результат получается и при конвертировании файла в формат m2v с помощью утилиты TMPGEnc 2.5.24. Разница заключается в том, что в данном случае негативное влияние технологии Нyper-Threading более существенно.

Собственно, мы уже имели возможность убедиться в том, что технология Hyper-Threading в двухъядерных процессорах в лучшем случае способна лишь не навредить. Однако, как выяснилось, есть и исключения из этого правила. Так, при конвертировании видеофайла в формат wmv утилитой Windows Media Encoder 9.0 в лидерах оказывается процессор Intel Pentium Processor Extreme Edition 840, который получает существенный прирост в производительности именно за счёт использования технологии Hyper-Threading.

А вот в таком пакете, как Adobe After Effects 6.5, всё достаточно традиционно. Результаты улучшаются по мере роста тактовой частоты, а использование технологии Huper-Threading несколько ухудшает результаты.

Рисунок 9. Результаты тестирования процессоров в задачах по обработке видеофайлов

В пакете Discreet 3ds Studio Max 7.0, который использовался для рендеринга трёхмерных сцен, результаты тестирования оказались довольно нетипичными. Фактически, это одно из немногих пользовательских приложений, которому технология Hyper-Threading идёт на пользу. То есть при рендеринге эффективно используются все четыре логических процессора, причём прирост производительности от использования технологии Hyper-Threading в данном случае даже выше, чем от увеличения тактовой частоты. К примеру, при увеличении тактовой частоты процессора на 200 МГц время рендеринга сокращается на 6%, а при использовании технологии Hyper-Threading – на 20%.

Вообще, можно ожидать, что использование технологии Hyper-Threading в двухъядерных процессорах принесёт выигрыш в производительности при рендеринге трёхмерных сцен и в других приложениях. Отсюда можно сделать вывод, что ниша, для которой предназначен процессор Intel Pentium Processor Extreme Edition 840 – это недорогие графические станции для дизайнеров.

Рисунок 10. Результаты тестирования в пакете 3ds Studio Max 7.0

Офисные приложения

Как видим, в офисных тестах (рис. 4) производительность всего семейства двухъядерных процессоров примерно одинакова и, конечно же, отличить «на глазок» один процессор от другого не представляется возможным. Более того, лидером в данном случае является процессор Intel Pentium D 840, а не Intel Pentium Processor Extreme Edition 840. Несмотря на одинаковую тактовую частоту, поддержка технологии Hyper-Threading в процессоре Intel Pentium Processor Extreme Edition 840 лишь ухудшает результаты, причём особенно негативно технология Hyper-Threading отражается именно на многозадачном тесте Business Winstone 2004 Multitasking test, где результаты процессора Intel Pentium Processor Extreme Edition 840 приблизительно равны результатам процессора Intel Pentium D 820.

Рисунок 5. Результаты тестирования в офисных приложениях

В тесте по скорости архивации с использованием утилиты WinRAR 3.00 технология Hyper-Threading позволяет получить незначительное преимущество при использовании процессора Intel Pentium Processor Extreme Edition 840. Собственно, это и понятно, ведь приложение является однопоточным, и технология Hyper-Threading позволяет более эффективно загрузить ресурсы процессора.

В то же время, если одновременно запустить две утилиты WinRAR 3.0, что позволяет выполнять параллельно два потока на отдельных ядрах процессора, то технология Hyper-Threading не только не способствует росту производительности, но и наоборот, фактически «убивает» процессор. Так, при одновременном выполнении двух утилит WinRAR 3.0 результаты процессора Intel Pentium Processor Extreme Edition 840 становятся хуже результатов процессора Intel Pentium D 820.

Рисунок 6. Сравнение времени архивации с использованием архиватора WinRAR 3.00

Ещё один пример реального офисного приложения, в котором двухъядерный процессор позволяет получить существенное преимущество – это программа распознавания текстов ABBYY FineReader 8.0. В общем-то, это и понятно, поскольку распознавание отдельных страниц текста – независимые друг от друга задачи, которые должны хорошо распараллеливаться.

Поэтому при использовании двухъядерного процессора одновременно распознаются две страницы текста (два потока с использованием двух ядер), а при использовании Intel Pentium Processor Extreme Edition 840 – четыре страницы (четыре потока с использованием четырёх логических процессоров), хотя стоит отметить, что технология Hyper-Threading в случае наличия двух ядер процессора не позволяет получить дополнительного преимущества в производительности.

Поиск золотой середины

Итак, давайте попробуем обобщить результаты тестирования двухъядерных процессоров Intel. В отношении технологии Hyper-Threading, реализованной в процессоре Intel Pentium Processor Extreme Edition, всё предельно ясно: вреда от неё больше чем пользы. Впрочем, вряд ли пользователю придётся рассуждать на тему блокировать или не блокировать данную технологию в BIOS, поскольку, как мы уже отмечали, данный процессор просто нельзя купить. Поэтому остаётся сделать выбор между тремя моделями. Если речь идёт о компьютере на базе двухъядерного процессора, который должен обладать максимальной производительностью, то выбор однозначен – это процессор Intel Pentium D 840. Однако сказать, что этот процессор оптимален, нельзя. Действительно, всё бы хорошо, но стоимость! А если при этом учесть, что в сравнении с процессором Intel Pentium D 820 прирост производительности в среднем составляет 10%, а стоимость отличается на 115%, то, согласитесь, есть о чём призадуматься. Если же сравнивать друг с другом процессоры Intel Pentium D 830 и Intel Pentium D 820, то окажется, что при усреднённой разнице в производительности на 5% их стоимость отличается всего на 30%. Согласитесь, что пара 5% и 30% куда лучше пары 10% и 115%.

Поэтому, если говорить об оптимальности, то выбор, конечно, следует делать между процессорами Intel Pentium D 830 и Intel Pentium D 820. И прежде чем вынести наш окончательный вердикт, напомним, что кроме производительности и стоимости эти два процессора отличаются ещё и тем, что модель Intel Pentium D 830 поддерживает технологию Intel Speed Step, а модель Intel Pentium D 820 – нет. Что это означает с точки зрения пользователя? Да хотя бы то, что данная технология снижает энергопотребление процессора Intel Pentium D 830 и позволяет, тем самым, создавать на его основе малошумные ПК. Впрочем, нужно отметить, что даже с использованием технологии Intel Speed Step энергопотребление процессора Intel Pentium D 830 остаётся выше, чем энергопотребление процессора Intel Pentium D 820.

Способы увеличения производительности процессора

Гонка тактовых частот, продолжавшаяся на протяжении многих лет, похоже, окончательно ушла в прошлое. За эти годы в умах пользователей укоренилось мнение, что именно тактовая частота процессора является показателем его производительности, однако планы компании Intel по наращиванию тактовых частот так и остались планами, и, скорее всего, увидеть процессор с тактовой частотой 10 ГГц нам предстоит весьма не скоро. По всей видимости, масштабирование процессоров по тактовой частоте оказалось не столь простой задачей, как предполагалось, и потому при сегодняшних технологических нормах производства процессоров и малоэффективных воздушных системах охлаждения добиться линейного масштабирования тактовой частоты процессоров не удаётся. Осознав, что увеличение прежними темпами тактовых частот процессоров не представляется невозможным, нужно было искать принципиально иные технологии увеличения производительности процессоров. Одновременно с этим необходимо было (по маркетинговым соображениям) убедить пользователей в том, что производительность процессора определяется не только и не столько его тактовой частотой. И первым шагом на пути к такому «перевоспитанию» пользователей стал отказ компании Intel от указания в названии процессора его тактовой частоты — на смену процессорам Intel Pentium 4 3,0 ГГц пришли загадочные обозначения вроде Intel Pentium 4 560 и т.п.

Давайте разберемся, от чего же в действительности зависит производительность процессора. Общепринято отождествлять производительность процессора со скоростью выполнения им инструкций программного кода. Производительность (Performance) — это отношение общего числа выполненных инструкций программного кода ко времени их выполнения:

В этом смысле производительность процессора отождествляется с количеством инструкций, выполняемых за секунду (Instructions rate). А поскольку одной из важных характеристик процессора является его тактовая частота, то желательно именно с ней связать производительность процессора. Это можно сделать, если количество инструкций, выполняемых за единицу времени, рассматривать как произведение количества инструкций, выполняемых за один такт процессора (Instruction Per Clock, IPC), на количество тактов процессора в единицу времени (тактовая частота процессора):

Количество тактов процессора в единицу времени – это и есть его тактовая частота (Frequency).

Таким образом, производительность процессора зависит в равной степени и от его тактовой частоты, и от количества инструкций, выполняемых за такт (IPC):

Впрочем, ожидать адекватного количеству процессоров роста производительности и в данном случае не приходится — многое зависит от типа решаемых задач, от реализации в серверной операционной системе поддержки SMP. Всегда можно найти такое приложение, которое в двухпроцессорной конфигурации будет показывать результаты ниже, чем в однопроцессорной, и потому любой «талантливый» программист вполне сможет свести на нет все преимущества многопроцессорной архитектуры. Между тем, кроме перечисленных способов увеличения общей производительности процессорной подсистемы, существуют технологии, позволяющие реализовать параллельное выполнение нескольких задач на одном процессоре. Такая многозадачность реализована в том или ином виде во всех современных процессорах. Отход от последовательного исполнения команд и использование нескольких исполняющих блоков в одном процессоре позволяют одновременно обрабатывать несколько процессорных микрокоманд, то есть организовывать параллелизм на уровне инструкций (Instruction Level Parallelism, ILP), что, разумеется, увеличивает общую производительность.

Технология Hyper-Threading – первый шаг к многоядерности

Анонсированная в 2002 году компанией Intel технология Hyper-Threading – пример многопоточной обработки команд. Данная технология является чем-то средним между многопоточной обработкой, реализованной в мультипроцессорных системах, и параллелизмом на уровне инструкций, реализованном в однопроцессорных системах. Фактически технология Hyper-Threading позволяет организовать два логических процессора в одном физическом. Таким образом, с точки зрения операционной системы и запущенного приложения в системе существует два процессора, что даёт возможность распределять загрузку задач между ними точно так же, как при SMP-мультипроцессорной конфигурации.

Посредством реализованного в технологии Hyper-Threading принципа параллельности можно обрабатывать инструкции в параллельном (а не в последовательном) режиме, то есть для обработки все инструкции разделяются на два параллельных потока. Это позволяет одновременно обрабатывать два различных приложения или два различных потока одного приложения и тем самым увеличить IPC процессора, что сказывается на росте его производительности.

В конструктивном плане процессор с поддержкой технологии Hyper-Threading состоит из двух логических процессоров, каждый из которых имеет свои регистры и контроллер прерываний (Architecture State, AS), а значит, две параллельно исполняемые задачи работают со своими собственными независимыми регистрами и прерываниями, но при этом используют одни и те же ресурсы процессора для выполнения своих задач. После активации каждый из логических процессоров может самостоятельно и независимо от другого процессора выполнять свою задачу, обрабатывать прерывания либо блокироваться. Таким образом, от реальной двухпроцессорной конфигурации новая технология отличается только тем, что оба логических процессора используют одни и те же исполняющие ресурсы, одну и ту же разделяемую между двумя потоками кэш-память и одну и ту же системную шину. Использование двух логических процессоров позволяет усилить процесс параллелизма на уровне потока, реализованный в современных операционных системах и высокоэффективных приложениях.

Команды от обоих исполняемых параллельно потоков одновременно посылаются для обработки ядру процессора. Используя технологию out-of-order (исполнение командных инструкций не в порядке их поступления), ядро процессора тоже способно параллельно обрабатывать оба потока за счёт использования нескольких исполнительных модулей. Идея технологии Hyper-Threading тесно связана с микроархитектурой NetBurst процессора Pentium 4 и является в каком-то смысле её логическим продолжением. Микроархитектура Intel NetBurst позволяет получить максимальный выигрыш в производительности при выполнении одиночного потока инструкций, то есть при выполнении одной задачи. Однако даже в случае специальной оптимизации программы не все исполнительные модули процессора оказываются задействованными на протяжении каждого тактового цикла. В среднем при выполнении кода, типичного для набора команд IA-32, реально используется только 35% исполнительных ресурсов процессора, а 65% исполнительных ресурсов процессора простаивают, что означает неэффективное использование возможностей процессора. Было бы вполне логично реализовать работу процессора таким образом, чтобы в каждом тактовом цикле максимально использовать его возможности. Именно эту идею и реализует технология Hyper-Threading, подключая незадействованные ресурсы процессора к выполнению параллельной задачи. Поясним всё вышесказанное на примере. Представьте себе гипотетический процессор, в котором имеется четыре исполнительных блока: два блока для работы с целыми числами (арифметико-логическое устройство, ALU), блок для работы с числами с плавающей точкой (FPU) и блок для записи и чтения данных из памяти (Store/Load, S/L). Пусть, кроме того, каждая операция осуществляется за один такт процессора. Далее предположим, что выполняется программа, состоящая из трёх инструкций: первые две — арифметические действия с целыми числами, а последняя — сохранение результата. В этом случае вся программа будет выполнена за два такта процессора: в первом такте задействуются два блока ALU процессора (красный квадрат на рис. 1), во втором — блок записи и чтения данных из памяти S/L.

Реализация параллелизма на уровне инструкций (Instruction Level Parallelism, ILP) В современных приложениях в любой момент времени, как правило, выполняется не одна, а несколько задач или несколько потоков (threads) одной задачи, называемых также нитями. Давайте посмотрим, как будет вести себя наш гипотетический процессор при выполнении двух разных потоков задач (рис. 2). Красные квадраты соответствуют использованию исполнительных блоков процессора одного потока, а синие квадраты — другого. Если бы оба потока исполнялись изолированно, то для выполнения первого и второго потока потребовалось бы по пять тактов процессора. При одновременном исполнении обоих потоков процессор будет постоянно переключаться между обоими потоками, следовательно, за один такт процессора выполняются только инструкции какого-либо одного из потоков. Для исполнения обоих потоков всего потребуется десять процессорных тактов.

Пусть имеется два потока команд, каждый из которых по отдельности выполняется за пять тактов процессора. Без использования технологии Hyper-Threading для выполнения обоих потоков потребовалось бы десять тактов процессора. А теперь выясним, что произойдет при использовании технологии Hyper-Threading (рис. 3). На первом такте процессора каждый из потоков задействует различные блоки процессора, поэтому выполнение инструкций легко совместить. Аналогичное положение вещей наличествует и на втором такте, а вот на третьем такте инструкции обоих потоков пытаются задействовать один и тот же исполнительный блок процессора, а именно блок S/L. В результате возникает конфликтная ситуация, и один из потоков должен ждать освобождения требуемого ресурса процессора. То же самое происходит и на пятом такте. В итоге оба потока выполняются не за пять тактов (как в идеале), а за семь.

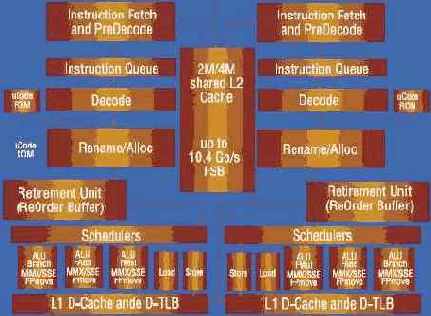

Conroe

На основе Intel Core Microarchitecture для рынка настольных компьютеров корпорация недавно выпустила ряд моделей двухъядерных процессоров, получивших наименование Intel Core 2 Duo (ранее известных как Conroe). Основные компоненты ядер процессора Intel Core 2 Duo представлены на рис. 3.

Рис. 3. Основные компоненты ядер процессора Intel Core 2 Duo

Intel Core 2 Duo — уже третье поколение двухъядерных процессоров Intel для ПК (напомним, что к первому поколению относятся модели Intel Pentium D, разработанные для настольных решений, а ко второму — Intel Core Duo для мобильных ПК).

Все выпущенные в настоящее время процессоры Intel Core 2 Duo, ориентированные на рынок настольных систем, созданы по технологии 65 нм и работают с процессорной шиной, унаследованной от своих предшественников. Для новых процессоров тактовая частота шины составляет 266 МГц, что обеспечивает передачу данных с частотой 1066 МГц и пиковый поток 8,5 Гбайт/с.

За исключением процессоров начального уровня, все модели оснащены 4 Мбайт кэш-памяти второго уровня (L2). Весь объем памяти доступен обоим ядрам, интегрированным в состав каждого из процессоров. Кэш-память первого уровня (L1) у всех моделей одинакова и составляет 32 Кбайт для инструкций (L1 Code) и 32 Кбайт для данных (L1 Data). Все модели поддерживают 64-битные расширения Intel Enhanced Memory 64 Technology (EM64T), SIMD инструкции SSE, SSE2 и SSE3, технологию виртуализации — Intel Virtualization Technology (VT) и бит Execute Disable, участвующий в системе информационной защиты. И, кроме того, поддерживают технологии управления энергопотреблением Enhanced Intel SpeedStep, Thermal Monitor 2. Основные параметры недавно выпущенных моделей для настольных систем представлены в таблице 2.

| Intel Core 2 Extreme X6800 | 2,93 | 1066 | 4 |

| Intel Core 2 Duo E6700 | 2,66 | 1066 | 4 |

| Intel Core 2 Duo E6600 | 2,40 | 1066 | 4 |

| Intel Core 2 Duo E6400 | 2,13 | 1066 | 2 |

| Intel Core 2 Duo E6300 | 1,86 | 1066 | 2 |

Таблица 2. Процессоры архитектуры Intel Core Microarchitecture для настольных ПК

Процессоры Intel Core 2 Duo, разработанные для настольных ПК, поддерживаются рядом наборов микросхем системной логики (чипсетами), среди которых семейство Intel 965 и Intel 975X.

Семейство наборов микросхем Intel 965 Express, ориентированное на массовые компьютеры (Mainstream Desktop), включает в себя варианты с графическим решением GMA3000, поддерживающим технологию Intel Clear Video.

Чипсет Intel 975X, разработанный для высокопроизводительных систем (Performance Desktop), поддерживает частоту передачи данных 1066 МГц, технологии повышения производительности подсистемы оперативной памяти и две видеокарты PCI Express x8/x16, способные работать параллельно. Данные наборы микросхем соответствуют требованиям ОС Microsoft Windows Vista Premium.

Intel Core 2 Extreme в действии

Евгений Рудометов, Виктор Рудометов

"IT News"

С развитием полупроводниковых технологий и совершенствованием внутренней архитектуры вычислительные возможности процессоров в сравнительно короткий срок возросли в десятки тысяч раз. Важнейшая же их характеристика — производительность — зависит от тактовой частоты, на которой работает ядро.

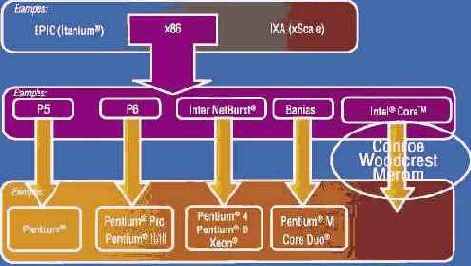

Intel Core Microarchitecture

Специалисты Intel предложили новую архитектуру, обеспечивающую эффективное снижение показателя Energy per Instruction (энергии, затраченной на выполнение одной инструкции). Данная архитектура, предоставляющая возможность реализации производительных экономичных многоядерных процессоров, получила наименование Intel Core Microarchitecture. Создана она группой конструкторов, ранее разработавших архитектуру ядра Banias. И хотя новинка, по мнению многих специалистов, ведет свою родословную от архитектуры P6, реализованной в Intel Pentium Pro и Pentium II/III, она является отдельной разработкой (рис. 2).

Рис. 2.Эволюция архитектуры x86

В продуктах, созданных на основе Intel Core Microarchitecture, нашли свое воплощение многие инновационные технологии, в частности Intel Wide Dynamic Execution, Intel Advanced Smart Cache, Intel Smart Memory Access, Intel Advanced Digital Media Boost, Intel 64 Technology, Intel Intelligent Power Capability. Данная архитектура стала основой для двухъядерных процессоров всех сегментов рынка ПК — настольных (Conroe), ноутбуков (Merom) и серверов (Woodcrest).

Ограничения частотного роста

С точки зрения пользователя, быстродействие процессора характеризуется временем выполнения определенного набора команд, последовательность которых образует компьютерную программу. Чем оно меньше, тем выше производительность. Иными словами:

производительность= (количество микрокоманд за такт) ×(тактовая частота)

Модели процессоров одного семейства, имеющие более высокие показатели тактовых частот, обладают и большей производительностью. Именно поэтому на протяжении сравнительно длительного времени повышение производительности процессора достигалось путем увеличения тактовых частот, на которых работают полупроводниковые ядра процессоров.

Однако безудержному росту тактовых частот препятствуют объективные физические законы, определяющие работу элементов уже нанометровых размеров. В ряду таких элементов нужно назвать прежде всего полупроводниковые транзисторы, изготовленные по технологии КМОП (CMOS). Параметры этих транзисторов (десятки миллионов которых составляют основу ядер процессоров) в значительной степени зависят от типоразмеров.

Изменение размеров определяется эволюцией технологических процессов, в соответствии с которыми осуществляется выпуск процессоров. Среди параметров, характеризующих техпроцесс, одним из основных выступают габариты полупроводниковых элементов (уменьшаемые каждые два года).

Совершенствование технологии и постепенное уменьшение размеров транзисторов способствуют улучшению их параметров, важнейшими из которых являются скоростные свойства. Благодаря уменьшению длины затвора в М раз пропорциональным образом возрастают частотные параметры и плотность размещения транзисторов.

| Длина затвора (X) | 1/M |

| Ширина затвора (Y) | 1/M |

| Толщина затвора (Z) | 1/M |

| Плотность размещения | M*M |

| Частота работы | M |

| Напряжение | 1/M |

Таблица 1.Масштабирование транзисторов

Однако работающие на высоких частотах транзисторы, десятки миллионов которых расположены на очень малой площади полупроводникового кристалла, оказывают друг на друга негативное влияние.

Это влияние можно легко проиллюстрировать на примере расположенных рядом проводников, соединяющих элементы в ядре процессора (рис. 1).

Входящие же в состав транзисторов p-n- переходы способны осуществлять непредусмотренное детектирование наведенных токов, их усиление и последующую передачу. Общая картина многократно усложняется, если учесть, что размеры транзисторов уже достигли тех значений, когда все большее влияние начинают оказывать квантовые эффекты. Миниатюризация полупроводниковых элементов, работающих на сверхвысоких частотах в условиях значительных электромагнитных помех, обусловливает стремительный рост неуправляемой составляющей токов в электронных схемах. Здесь следует напомнить, что для сохранения устойчивости работы электронных схем токи, контролируемые работающими элементами, должны быть больше неуправляемых токов утечки. В результате негативных явлений, порождаемых процессами миниатюризации, неуправляемые токи, основу которых составляют токи утечки, а также паразитные токи, связанные с ростом частоты переключения транзисторов, препятствуют снижению теплообразования процессоров за счет миниатюризации элементов. Это означает, что ожидаемого существенного снижения теплообразования не происходит, несмотря на уменьшение напряжения питания, достигнутое благодаря уменьшению типоразмеров транзисторов. Доля указанной неконтролируемой части электрического тока, и без того довольно значительная, еще более увеличивается с ростом частоты. Однако обратная сторона частотного роста — опять же сравнительно быстрое увеличение теплообразования процессоров. Учитывая же тот факт, что площадь кристалла процессора практически остается постоянной, рост теплообразования способствует увеличению плотности энергии. Высокая же мощность теплообразования сопровождается перегревом внутренних структур процессора, что негативно сказывается на работоспособности, а также усиливает и ускоряет процессы деградации полупроводников.

Производительность

Новая процессорная архитектура, реализующая перечисленные выше технологии, обеспечивает двухъядерным процессорам высокий уровень производительности при значительном сокращении энергопотребления, а следовательно, и теплообразования. В материалах, представленных на весенних сессиях Intel Developer Forum, фигурирует 40-процентное повышение производительности при таком же снижении теплообразования.

Теплообразование, как известно, определяется показателем TDP (Thermal Design Power — максимальная мощность теплообразования микросхемы). Для верхней модели в настоящее время он соответствует 75 Вт, для остальных — 60 Вт. Эти значения существенно ниже аналогичных показателей двухъядерных предшественников, в которых TDP достигал 130 Вт.

Что же касается производительности, обеспечиваемой процессорами с новой архитектурой, то ее оценку целесообразно осуществить в процессе тестирования. В качестве объекта тестирования была использована модель Intel Core 2 Extreme X6800, обеспечивающая наивысший уровень производительности среди процессоров Intel, выпущенных в настоящее время для сектора настольных компьютеров.

В роли эталона в исследовании выступил Intel Pentium D 820 на базе архитектуры NetBurst, относящийся к предыдущему поколению двухъядерных процессоров, разработанных для настольных компьютеров. Эта модель входит в группу продуктов с кодовым именем Smithfield и создана по технологии 90 нм. Тактовая частота работы ядер — 2,8 ГГц, кэш-память L1 Data имеет объем 16 Кбайт, L1 Trace — 12 Kuops, L2 — 1024 Кбайт.

В качестве основы тестовой системы использована материнская плата Intel D975XBX, созданная на основе «топового» чипсета Intel 975X. Основные параметры данной платы приведены в таблице 3.

| Процессор | Intel Core 2 Extreme / Duo, Pentium Extreme Edition / D / 4 c LGA775 и шиной 1066/800 МГц |

| Чипсет | Northbridge: Intel 82975X (MCH); Southbridge: Intel 82801GR (ICH7R) |

| Оперативная память | Два канала, четыре DIMM DDR2 667/533 SDRAM, ECC/non-ECC. Максимальный объем — до 8 Гбайт |

| Видео | 1–3 видеоадаптера в слотах стандарта PCI Express x16 (электрические — x16/x8, x8, x4), поддержка ATI CrossFire |

| Аудио | HD Audio, до восьми каналов |

| IDE | Один порт IDE (два устройства) с UltraDMA 100/66/33 |

| Serial ATA | Четыре порта Serial ATA II (300 Мбайт/с) c поддержкой RAID; четыре порта Serial ATA (150 Мбайт/с) c поддержкой RAID |

| USB 2.0 | Восемь портов USB 2.0/1.1 (четыре — через кабель) |

| IEEE1394 | Два порта IEEE1394a (один — через кабель) |

| LAN | Gigabit (10/100/1000 Mбит/c) LAN с реализацией посредством Intel 82573L Gigabit Ethernet Controller |

| Порты задней панели | Порты PS/2 клавиатуры и мыши; один параллельный порт LPT; один последовательный порт COM; четыре порта USB 2.0/1.1; один порт IEEE 1394a; один порт RJ45; один Coaxial Digital Line Out; один Optical Digital Line Out; пять разъемов аудио |

| Слоты | Три слота конструктива PCI Express x16; два слота PCI |

| Форм-фактор | ATX, размеры платы: 305×244 мм |

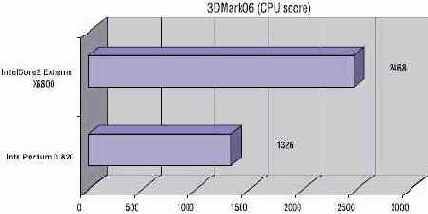

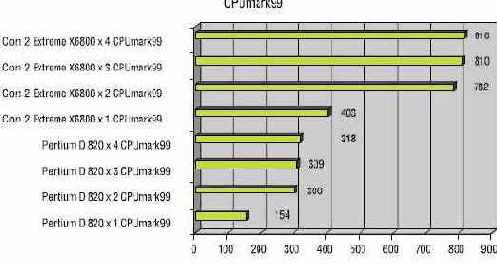

Таблица 3. Основные параметры материнской платы Intel D975XBX В ходе тестирования оба процессора — исследуемый Intel Core 2 Extreme X6800 и эталонный Intel Pentium D 820 — корректно опознавались как двухъядерные процессоры. Результаты выполнения теста 3DMark06 (CPU score) представлены в таблице 4 и на рис. 4.

| Intel Pentium D 820 | 1326 |

| Intel Core 2 Extreme X6800 | 2468 |

| 1×CPUmark99 | 403 | 403 | |||

| 2×CPUmark99 | 375 | 407 | 782 | ||

| 3×CPUmark99 | 220 | 378 | 212 | 810 | |

| 4×CPUmark99 | 210 | 221 | 190 | 195 | 816 |

| 1×CPUmark99 | 154 | 154 | |||

| 2×CPUmark99 | 135 | 165 | 300 | ||

| 3×CPUmark99 | 165 | 71,3 | 72,7 | 309 | |

| 4×CPUmark99 | 135 | 66,8 | 58,7 | 57,5 | 318 |

Действительно, модель Intel Core 2 Extreme X6800 при превышении на 4,6 % внутренней тактовой частоты по сравнению с Intel Pentium D 820 в тесте 3DMark06 (CPU score) демонстрирует на 86 % большую производительность в сравнении с предшественником. Не менее интересны результаты одновременного выполнения нескольких копий CPUmark99. В случае запуска одной копии превышение составляет 162%, при двух — 161%. С ростом числа копий теста CPUmark99 преимущество в производительности процессора новой архитектуры сохраняется. В заключение необходимо напомнить, что в тестах использовался инженерный сэмпл модели Intel Core 2 Extreme X6800, а, как показывает опыт, по мере совершенствования технологии и внутренней архитектуры параметры процессоров улучшаются. Остается добавить, что процессоры, созданные по новой архитектуре, характеризуются весьма низким теплообразованием, что позволяет создавать на их базе компьютеры с низким уровнем акустического шума. Процессор Intel Core 2 Extreme X6800

и материнская плата Intel D975XBX

предоставлены московским офисом корпорации Intel

Регулирование энергопотребления

В попытках решить проблему снижения энергопотребления своих изделий, конструкторы принялись встраивать в ядра специальные цепи (их функционирование поддержано системным программным обеспечением), которые регулируют работу процессоров и обеспечивают, в зависимости от вычислительной нагрузки и условий эксплуатации, установку оптимальных электрических и частотных режимов. То есть в случае снижения вычислительной нагрузки происходит уменьшение тактовой частоты работы ядра.

Кстати, при снижении тактовой частоты процессора ниже штатной величины напряжение питания его ядра может быть соответствующим образом снижено без нарушения устойчивости работы системы, и это позволяет снизить теплообразование процессора. Будучи стандартными для портативных компьютеров, такие операции, выполняемые в автоматическом режиме аппаратно-программным обеспечением, предназначены для экономии энергии батарей. Однако понижение напряжения и частоты уже используется и для моделей серверного сектора, и сектора настольных компьютеров, что позволяет не только уменьшить энергопотребление, но и существенно снизить тепловую нагрузку на полупроводниковые кристаллы ядер процессоров.

Для оценки эффективности подобных технологий для снижения тепловой нагрузки на ядро процессора целесообразно воспользоваться следующей формулой:

P ≈ C × V2 × F,

где P — тепловая мощность процессора, С — коэффициент, учитывающий взаимную емкость элементов ядра процессора и зависящий от архитектуры его ядра (обычно возрастает с увеличением плотности размещения элементов на кристалле микросхемы), V — напряжение питания ядра, F — тактовая частота.

Данное выражение легко приводится к следующему виду:

В этом уравнении, связывающем основные характеристики теплообразования, переменные с индексом k обозначают соответствующие параметры изменяемых режимов, а переменные с нулевым индексом — параметры штатного режима.

Приведенная формула показывает, что уменьшение тактовой частоты и, как следствие, возможность уменьшения напряжения питания обеспечивают значительное снижение мощности теплообразования.

Так, например, 20%-ное уменьшение тактовой частоты и напряжения уменьшает теплообразование в два раза. Снижение же производительности можно компенсировать использованием нескольких ядер.

В результате, как показывают расчеты и практическая реализация, замена верхних моделей на процессоры с несколькими ядрами способна обеспечить существенный прирост производительности при приемлемом теплообразовании. (Первые такие процессоры, ориентированные на сектор настольных компьютеров и созданные на основе архитектуры NetBurst, вывела на рынок Intel.)

Дальнейшего снижения энергопотребления можно достичь простым переходом на архитектуру процессоров Intel Pentium M или более совершенную Intel Core Duo с соответствующим увеличением тактовых частот до уровня производительности Intel Pentium 4.

Но конструкторы корпорации Intel пошли другим путем.

Celeron M

Если Pentium M уже явно доживают свой век, то от процессоров Celeron M компания Intel пока отказываться не собирается. Более того, уже в этом году данное семейство пополнилось четырьмя совершенно новыми моделями, производимыми по технологическому процессу 65 нм. Правда, оба основных минуса Celeron M (кэш второго уровня объёмом 1 Мбайт и отсутствие поддержки SpeedStep), к сожалению, никуда не делись.

|

Модель |

ТП |

Кол-во ядер |

Частота |

FSB |

Кэш L2 |

VT |

EIST |

EM64T |

XD |

TDP |

|

Celeron M 430 |

65 нм |

1 |

1,73 ГГц |

533 МГц |

1 Мбайт |

– |

– |

+ |

27 Вт | |

|

Celeron M 420 |

65 нм |

1 |

1,60 ГГц |

533 МГц |

1 Мбайт |

– |

– |

– |

+ |

27 Вт |

|

Celeron M 410 |

65 нм |

1 |

1,46 ГГц |

533 МГц |

1 Мбайт |

– |

– |

– |

+ |

27 Вт |

|

Celeron M 390 |

90 нм |

1 |

1,70 ГГц |

400 МГц |

1 Мбайт |

– |

– |

– |

+ |

21 Вт |

|

Celeron M 380 |

90 нм |

1 |

1,60 ГГц |

400 МГц |

1 Мбайт |

– |

– |

– |

+ |

21 Вт |

|

Celeron M 370 |

90 нм |

1 |

1,50 ГГц |

400 МГц |

1 Мбайт |

– |

– |

– |

+ |

21 Вт |

|

Celeron M 360J |

90 нм |

1 |

1,40 ГГц |

400 МГц |

1 Мбайт |

– |

– |

– |

+ |

21 Вт |

|

Celeron M 360 |

90 нм |

1 |

1,40 ГГц |

400 МГц |

1 Мбайт |

– |

– |

– |

– |

21 Вт |

|

Celeron M 350J |

90 нм |

1 |

1,30 ГГц |

400 МГц |

1 Мбайт |

– |

– |

– |

+ |

21 Вт |

|

Celeron M 350 |

90 нм |

1 |

1,30 ГГц |

400 МГц |

1 Мбайт |

– |

– |

– |

– |

21 Вт |

|

Celeron M ULV 423 |

65 нм |

1 |

1,06 ГГц |

533 МГц |

1 Мбайт |

– |

– |

– |

+ |

5,5 Вт |

|

Celeron M ULV 383 |

90 нм |

1 |

1,00 ГГц |

400 МГц |

1 Мбайт |

– |

– |

– |

+ |

7 Вт |

|

Celeron M ULV 373 |

90 нм |

1 |

1,00 ГГц |

400 МГц |

512 Кбайт |

– |

– |

– |

– |

7 Вт |

Учитывая, что технологическое отставание этой линейки от более производительной части модельного ряда в очередной раз увеличилось, можно предположить, что к следующему году Intel откажется-таки от этого семейства. Как минимум в следующем поколении аналога Celeron M очень хотелось бы видеть технологию SpeedStep, а уж на характеристики, влияющие на производительность, можно закрыть глаза.

Далее

Оригинал статьи на "www.ferra.ru"

P2.shtml

Pentium M

Начнём с самого, пожалуй, известного и заслуженного мобильного процессора в мире – Pentium M. С момента публикации статьи «Процессоры для ноутбуков», состоявшейся почти полтора года назад, модельный ряд этого семейства CPU Intel изменился не слишком сильно. Добавились топовые модели во всех трёх подсемействах – «обычном», LV и ULV, – и исчезли модификации, основанные на устаревшем ядре Banias.

|

Модель |

ТП |

Кол-во ядер |

Частота |

FSB |

Кэш L2 |

VT |

EIST |

EM64T |

XD |

TDP |

|

Pentium M 780 |

90 нм |

1 |

2,26 ГГц |

533 МГц |

2 Мбайт |

+ |

– |

+ |

27 Вт | |

|

Pentium M 770 |

90 нм |

1 |

2,13 ГГц |

533 МГц |

2 Мбайт |

– |

+ |

– |

+ |

27 Вт |

|

Pentium M 765 |

90 нм |

1 |

2,10 ГГц |

400 МГц |

2 Мбайт |

– |

+ |

– |

– |

27 Вт |

|

Pentium M 760 |

90 нм |

1 |

2,00 ГГц |

533 МГц |

2 Мбайт |

– |

+ |

– |

+ |

27 Вт |

|

Pentium M 755 |

90 нм |

1 |

2,00 ГГц |

400 МГц |

2 Мбайт |

– |

+ |

– |

– |

27 Вт |

|

Pentium M 750 |

90 нм |

1 |

1,86 ГГц |

533 МГц |

2 Мбайт |

– |

+ |

– |

+ |

27 Вт |

|

Pentium M 745 |

90 нм |

1 |

1,80 ГГц |

400 МГц |

2 Мбайт |

– |

+ |

– |

– |

27 Вт |

|

Pentium M 740 |

90 нм |

1 |

1,73 ГГц |

533 МГц |

2 Мбайт |

– |

+ |

– |

+ |

27 Вт |

|

Pentium M 735 |

90 нм |

1 |

1,70 ГГц |

400 МГц |

2 Мбайт |

– |

+ |

– |

– |

27 Вт |

|

Pentium M 730 |

90 нм |

1 |

1,60 ГГц |

533 МГц |

2 Мбайт |

– |

+ |

– |

+ |

27 Вт |

|

Pentium M 725 |

90 нм |

1 |

1,60 ГГц |

400 МГц |

2 Мбайт |

– |

+ |

– |

– |

27 Вт |

|

Pentium M LV 778 |

90 нм |

1 |

1,60 ГГц |

400 МГц |

2 Мбайт |

– |

+ |

– |

+ |

10 Вт |

|

Pentium M LV 758 |

90 нм |

1 |

1,50 ГГц |

400 МГц |

2 Мбайт |

– |

+ |

– |

+ |

10 Вт |

|

Pentium M LV 738 |

90 нм |

1 |

1,40 ГГц |

400 МГц |

2 Мбайт |

– |

+ |

– |

– |

10 Вт |

|

Pentium M ULV 753 |

90 нм |

1 |

1,20 ГГц |

400 МГц |

2 Мбайт |

– |

+ |

– |

+ |

5 Вт |

|

Pentium M ULV 733J |

90 нм |

1 |

1,10 ГГц |

400 МГц |

2 Мбайт |

– |

+ |

– |

+ |

5 Вт |

|

Pentium M ULV 733 |

90 нм |

1 |

1,10 ГГц |

400 МГц |

2 Мбайт |

– |

+ |

– |

– |

5 Вт |

|

Pentium M ULV 723 |

90 нм |

1 |

1,00 ГГц |

400 МГц |

2 Мбайт |

– |

+ |

– |

– |

5 Вт |

Уже сейчас понятно, что Pentium M продержится на рынке недолго, ведь новые процессоры, основанные на архитектуре Core, стоят почти тех же денег и обеспечивают более высокий уровень производительности при близком энергопотреблении. Конечно, пока это справедливо, лишь если говорить о перспективе. На данный момент и в ближайшие пару месяцев ноутбук на Pentium M станет оптимальным выбором для тех, кто хочет получить устройство действительно высокого уровня за относительно небольшие деньги, цены на «старые» модели с Pentium M сейчас сильно снижены.

Процессоры Intel для ноутбуков

Алексей Дрожжин, Тестовая лабораторияFerra

Данная статья представляет собой справочный материал, призванный помочь читателям разобраться в модельном ряду процессоров Intel, предназначенных для использования в портативных компьютерах. Здесь рассмотрены три поколения: Celeron M и Pentium M, Core Solo и Core Duo и новейшее Core 2 Duo.Модельный ряд мобильных процессоров Intel претерпел значительные изменения с начала 2006 года и на данный момент представлен тремя поколениями, в которых ко всему прочему имеются отдельные подсемейства. Всего же на данный момент линейка процессоров Intel для ноутбуков состоит из 50 (!) с лишним моделей, каждая из которых имеет свои нюансы. К тому же у обоих ведущих производителей вошло в моду именовать процессоры абстрактными модельными номерами, нередко присвоенными отдельным CPU не вполне логично. Более того, оба чипмейкера употребляют для мобильных процессоров сразу две существенно отличающихся системы нумерации. Сравните, например, Intel Pentium M 755 и Core Duo T2300 или AMD Sempron 3100+ и Turion MT-37.

Естественно, что неподготовленному пользователю разобраться во всём этом разнообразии нелегко. Поэтому мы решили собрать всю информацию по процессорам Intel, так сказать, «в одном месте» и впоследствии будем ссылаться на данный материал при рассмотрении попадающих к нам на тестирование ноутбуков. Итак, приступим.

Что позволяет делать iPAT?

iPAT включает несколько компонентов: материнскую плату с поддержкой iPAT (который представляет собой расширенный BIOS), клиентское и серверное ПО. Причем, как мы уже говорили, при покупке платы с поддержкой iPAT пользователь получает комплект ПО Intel Platform Administrator. То есть для развертывания сети с iPAT достаточно приобрести компьютеры с материнскими платами, поддерживающими iPAT, и развернуть входящее в комплект ПО.

Схема.Архитектура решения

Главная особенность плат с поддержкой iPAT в том, что расширенный BIOS позволяет задать параметры IP рабочей станции, указав их вручную или с помощью DHCP, и активировать работу сетевого интерфейса, благодаря чему уже на этапе загрузки система может подключиться к серверу с административной частью iPAT и автоматически выполнить назначенные задания. Самое интересное, что задания могут быть не только такие, как развертывание образа системы, но и развертывание пакетов программ или их удаление. Вся работа ведется еще до загрузки ОС, средствами BIOS. Благодаря этому iPAT способен защитить ПК как от недобросовестных пользователей, так и от вирусов, которые могут нарушить работоспособность системы. Для этого администратору достаточно перезагрузить ПК и восстановить изначальное состояние системы. При этом все изменения, сделанные недобросовестным пользователем или вирусом, исчезнут.

Технология позволяет удаленно включать, выключать и перезагружать клиентские ПК. Причем независимо от текущего состояния рабочей станции. Эта функция также реализована средствами iPAT BIOS. Еще одной возможностью iPAT можно считать физическую защиту ПК. Конечно, речь не идет о замках и цепях, скорее о сигнализации. Так, все изменения конфигурации ПК немедленно отображаются на сервере. Это касается не только аппаратной части, но и программного обеспечения, в том числе драйверов. Администратор всегда будет знать об изменениях в аппаратной части, будь то извлечение флэш-диска или замена видеокарты, а также об установке или удалении программ.

Другими словами, iPAT помогает централизованно выполнять и автоматизировать рутинные задачи администраторов, что сокращает время обслуживания компьютерного парка организации, а значит, повышает эффективность использования IT.

Intel PAT — еще один способ продавать материнские платы

Андрей Пировских, Андрей Шуклин

"Экспресс Электроника"

Летом 2006 года компания Intel представила технологию iPAT, которую сначала применили в Китае, потом в Малайзии и Турции, а затем - и в России. Действительно ли данная технология надежна и полезна или это удобный маркетинговый трюк для продажи материнских плат? Попытаемся разобраться.

Существует немало методик и технологий управления компьютерным парком, что совершенно неудивительно. Вопросы управления и контроля работы решались еще со времен мейнфреймов — ведь каждая критически важная система должна быть максимально управляема. Однако информационные технологии проникают во все сферы нашей жизни, и управлять сегодня надо практически всем, поскольку любая система или сеть со временем насчитывает все большее количество элементов. Так или иначе тема управления ресурсами, оперативного контроля, обеспечения работоспособности и безопасности весьма горячая. В этом смысле новое решение от Intel, позволяющее управлять компьютерными системами, оказалось кстати.

Кому это не нужно?

iPAT позволяет выполнять достаточно широкий спектр задач по администрированию платформ, что, с одной стороны, является плюсом. Но если речь идет о компании, в которой уже установлена система управления компьютерным парком, надо ли этой компании задумываться о приобретении нового поколения компьютеров с поддержкой iPAT? Пожалуй, нет. Ведь если в компании уже применяется одна система управления, зачем без лишней надобности интегрировать ее со второй системой и создавать себе ненужные трудности? Логичнее установить новые компьютеры с поддержкой технологии, подобной AMT, а с операционной системой общаться на уровне того программного обеспечения, которое уже используется в компании.

Впрочем, и учебным учреждениям имеет смысл закупать компьютеры с поддержкой iPAT, только если речь идет о построении целого или нескольких компьютерных классов — в противном случае администрирование окажется столь же затруднительным, и администратору придется появляться в классе, чтобы настроить часть компьютеров, работающих без поддержки iPAT.

Кому это нужно?

Для начала уточним, что платформы с поддержкой iPAT (Intel Platform Administration Technology) поставляются не во все страны, а лишь в развивающиеся — для прочих потребителей предусмотрена более полная технология vPro, которая позволяет не только контролировать состояние ПК и восстанавливать ПО, но и пользоваться технологиями виртуализации и многими другими наработками Intel. Что касается iPAT, новая технология нашла себе применение в китайских интернет-кафе, а не так давно и в российских образовательных учреждениях. На самом деле эти применения можно считать вполне предсказуемыми. Специфика многих структур, в том числе учебные заведения и компьютерные клубы, такова, что зачастую бывает необходимо давать конечным пользователям ПК административные права, например для обучения администрированию или системному программированию, а также для работы игр.