Mac на процессоре Intel: по следам сенсации

Владимир Новиков aka VN_MAClover

Итак, keynote Стива Джобса завершён, можно сделать некоторые выводы. Джобс вышел на сцену в брюках, вместо обычных джинсов, что прямо указывало на то, что "базар пойдёт серьёзный". И действительно...

CEO Apple открыто раскритиковал IBM за

неспособность производить в нужном количестве процессоры G5, особенно их двухъядерные версии, давно объявленные, но до сих пор недоступные; отсутствие прогресса в плане тактовой частоты, которая за два года выросла (всего-то:-)) с 2.0 до 2.7 GHz); нежелание произвести версию для ноутбуков.После чего объявил о том, что, начиная с 2006 года, вся линейка компьютеров Apple постепенно перейдёт на процессоры от Intel.

Он показал Mac OS X 10.4 Tiger, работающую на Pentium 4, и заявил, что Xcode 2.1 позволит компилировать как для G3/G4/G5, так и для x86. А Mac OS X 10.5 (Leopard) будет представлен для обеих архитектур сразу. Кроме того, был представлен новый эмулятор Rosetta, который будет работать под х86 и на ходу перекомпилировать код PowerPC на почти 100% скорости. Поскольку эмулятор делает сам Apple, можно быть уверенным в том, что так и будет. Стив Джобс показал Adobe PhotoShop CS и MS Office, которые работали так же быстро, что и на среднестатистических сегодняшних Маках.

Разработчикам уже сегодня доступен компьютер G5 с процессором Intel.

А теперь выводы. Сразу предупреждаю, что всё это - только моё личное мнение. Но я считаю для себя возможным сделать такой анализ, исходя из двух истин. Истина первая, историческая: Apple НИКОГДА не говорила о будущем. Значит, появилась необходимость... Истина вторая, экономическая: два года без новых моделей не прожить ни одной компьютерной фирме. Это означает, что за пазухой спрятан большой кирпич...

Итак:

Ничего нового сказано не было, и так всем было известно, что Mac OS X давно и прекрасно работает на х86. Не будем забывать, что корнями он восходит к Next, а FreeBSD, на базе которого построен Darwin, вообще изначально только под х86 архитектуру и существовал.Да и сам Darwin всегда был доступен в версии для х86, а уж перекомпилировать интерфейс... Разработчикам дали понять, что Classic настал конец. Сразу поясняю, что Classic - это что-то типа поддержки приложений Windows 3.11 в Windows 95. Но и это не новость. Вот уже 2 года как OpenFirmware (маковская разновидность BIOS) всех Маков не поддерживает запуск Mac OS 9.2.2. Для работы со старыми приложениями надо либо покупать б/у Маки, либо работать в Classic, т.е. в эмуляции. Да, есть Rosetta, но это будет эмулятор на эмулятор... Тем же разработчикам более чем прозрачно намекнули, что не надо использовать чужие компиляторы (Metrowerks встал и раскланялся), а осваивать Xcode. Но вот беда, Xcode заточен под Cocoa софт, а с Carbon приложениями работает хуже. Carbon приложения - это старые приложения от "девятки", которые сделали совместимыми с Mac OS X, но не до конца, а просто почистив код. То есть это лучше Classic, но хуже Cocoa, родных приложений для Mac OS X. Большой камень в огород Microsoft и Adobe, руководство которых поспешило выйти на сцену и громко заявить, что всё перепишет в лучшем виде... Все уже поняли, что надо писать только и исключительно Cocoa приложения. Замечу в скобках, что Cocoa приложения давно уже совместимы с Linux, так как есть такая вещь как GNUStep. В качестве примера приведу очень хороший и незаслуженно неизвестный почтовик GNUmail. Новая версия Xcode позволит компилировать либо отдельные версии для двух поддерживаемых архитектур, либо fat binary, так хорошо знакомую мне по эпохе перехода с архитектуры 68xxx на Power. Ничего про новые машины сказано не было... А теперь смотрим. Apple форсирует тотальный перевод всех приложений на Cocoa, а также их чистку на предмет отсутствия всяких хаков, которые могут помешать при компиляции под х86. Adobe и Microsoft начинают, утерев слёзы, переписывать свои монстроидальные софтины, к великой радости окружающих. А дальше...

Apple в состоянии выпустить машины с ЛЮБЫМ из mainstream камней, IBM, Intel, AMD...

Операционка позволяет, Cocoa софт надо лишь перекомпилировать. Если подтянется IBM, то и чудненько, если нет - Intel inside в новых ноутах.

Одним словом, не могу не снять шляпу перед очередным гениальным ходом Джобса. Как MacUser со стажем, я должен был бы рвать и метать, что меня кинули... а я радуюсь. У нас опять есть выбор, платформа будет жить.

И последнее. Джобс ясно сказал, что железо будет делать Apple. То есть фантазировать по поводу работы Mac OS X на самосборных Пентюхах явно не нужно. Наверняка появятся хаки, но это будет уже не то...

Под конец и по горячим следам, несколько постоянно встречающихся вопросов и мои попытки дать на них ответы (опять таки, отражающие лишь мое личное мнение):

В1: Они, падлы, нас подло кинули, я только что себе купил iMac, iBook, Power что-то там...

О1: Ну а я приятелю посоветовал Р4 за неделю до выхода ADM dual core камней. И что? Когда серия Х доходит до магазинов, пресса вовсю тестирует серию Х+1, а на заводах уже перестраивают линии на серию Х+2. Кроме того, человеческим языком сказали, что в течение многих лет будут выходить машины на базе PowerPC, если IBM наладит выпуск камней, а также будет возможность компилировать под них. ОК, Маки служат в среднем дольше IBM-PC. Возьмём сегодняшний Мак, поставляемый с Тигром. Леопард будет в начале 2007 года, в нём поддержка PowerPC сохранится полностью, так как на тот момент переход не будет завершён, да и установленная база будет против... В 2009 году будет версия 10.6 (что ещё из кошек осталось? Прим. ред.: если по нарастающей крутизне, боюсь, что только ископаемые махайроды и смилодоны - А.Ф.), там явно тоже всё будет в порядке. Даже если представить себе, что в 2011 поддержку прекратят, скажем прямо, этот Мак доживёт своё спокойно...

В2: А вот Sony и MS бегут на поклон к IBM и будут использовать в новых игровых приставках камень Cell. А Apple что, самый умный, что ль?

О2: Процессор Cell пока существует только в виде прототипа, равно как и процессор G5 с частотой 3.5 GHz, его версия для ноутов, ну и так далее.

Ничто не помешает Apple использовать этот камень, если вдруг он будет хорош до безобразия, а у Intel возникнут проблемы. Сегодня Джобс дал понять всем, что незаменимых нет, только и всего.

В3: А AMD всё равно круче!

О3: Ничто не мешает Apple производить машины на базе камней AMD. Ещё раз, сегодня было сделано заявление о том, что "мы можем всё", а машины будут через год. За это время много воды утечёт...

В4: Тогда уж пусть просто делают софт, который будет ставиться на любые машины.

О4: Спасибо, уж лучше Вы к нам... Apple делает рабочие станции, у которых не бывает проблем с драйверами, если использовать сертифицированное оборудование. Уже сейчас разработчикам продают Power Mac G5 с камнем от Intel, а не Dell какой-нибудь. Ясно, что в машинах будет много своих технологий. Ничто не помешает умельцам поставить Mac OS X на самосборную машину, но официально это не будет разрешено, во всяком случае на первых порах.

В5: Всё равно обидно, ведь они были не такие, как все...

О2: А они были, есть и будут не такие, как все. Психология осталась прежней: делать машины, которые работают. При этом пользователь может даже не знать, как они устроены. Но Apple вынужден быть прагматиком и отказываться от проприетарных технологий. Шина NUBUS, порт ADB, винты SCSI, наконец, экраны с подключением через ADC (Apple Display Connector). Просто никто не хотел производить совместимую периферию...

В6: Конец, теперь будут вирусы, трояны, пиратские диски и Маки по 300 баксов на Савёловском.

О6: Пиратские диски и так есть, Маков за 300 у.е. пока не будет (см. выше), а вирусы и трояны пишутся под ОСь, а не под камень. А Mac OS X - это UNIX-подобная система, и трояна туда засадить трудно. Несколько попыток написать гадость были, но без соучастия пользователя (пусть и невольного) не обойтись...

В7: А тогда зачем это всё?

О7: Истинные мотивы знает только Джобс, будущее покажет. Однако, ИМХО, дело в софте. Аналогичная ситуация сложилась в момент перехода с архитектуры 68ххх на PowerPC.

Старый софт работал через эмулятор, и разработчики не спешили с его портированием. Так и теперь. До сих пор есть софт, который существует только под "девятку" (некоторые функции Cleaner), масса Carbon софта (вся линейка Adobe, Microsoft, суперпопулярный Graphic Converter...), а на Cocoa пишет сам Apple и разработчики свободного ПО. Разумеется, масса компаний предпочла полностью переписать софт в Cocoa (Nisus Writer), но тяжёлая артиллерия пока выжидала. А это значит, что софт не может быть по определению оптимизирован под новые камни и 64-разрядную архитектуру, к примеру. Или над этим надо специально работать...

В8: А я не знаю Objective-C...

О8: Не будучи разработчиком, мне трудно сказать, насколько легко разрабатывать Cocoa приложения на С/С++. Однако знаю, что это возможно. Но ведь есть ещё Java, котоая прекрасно интергирована в систему и позволяет общаться с Cocoa. Проект Neooffice/J прекрасно работает. А ещё есть Qt/Mac для любителей С++. Крупных проектов пока нет, однако MyPasswordSafe, к примеру, прекрасно работает. Наконец, есть порт GTK+, правда, пока он далёк от завершения. Но Abiword уже пашет. Одним словом, разработка приложений для Мака - уже не проблема. Более того, GTK+ и QT кроссплатформенны по определению, про Java и говорить нечего, а Cocoa приложения совместимы с Linux благодаря проекту GNUStep.

В9: А я всё-таки не буду переписывать мою гениальную Carbon программу.

О9: Тоже не проблема, XCode 2.1 работает с Carbon софтом и позволит делать версию для х86, однако Appele предупреждает, что ручками придётся работать значительно больше... может на Cocoa перейти сейчас, чтобы потом не было мучительно больно и обидно...?

Mactel, или блеск и нищета бенчмарок

Владимир Новиков aka VN_MAClover

Данная тема может стать прекрасным сюжетом для социологического исследования наших реакций на корпоративные маркетинговые слоганы. Всё есть, и непонимание, и тупое слияние в экстазе, и отрицание, недоверие и всё, что хочешь... Психолога в студию.

Кроме того, это наглядная иллюстрация двух старинных русских пословиц, а именно "шило в мешке не утаишь" и "всё тайное становится явным". О себя добавлю, что в XXI веке быстро становится... В понедельник Apple 100 раз просила не публиковать бенчмарки тестовых машин, в среду бенчмарки эти уже валялись по всей Сети...

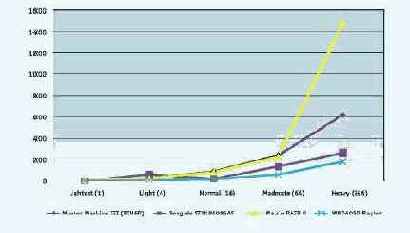

Одним словом, так. На нескольких "яблочных" форумах вовсю разгорается перепалка под общим названием "Стив опять всех надул по полной..." Предметом разборок стали обнародованные самим же Стивом Джобсом в апреле бенчи, сравнивающие лучших представителей архитектуры х86 и новые G5 2.7 GHz. Ясно, кто там одерживает верх по всем пунктам. Один из французских сайтов скомпилировал эти бенчи в виде графики.

Очень забавно, что кричат громче всех те, кто в апреле с пеной у рта доказывал, что для бенчей были выбраны наиболее благоприятные для G5 тесты, а в остальных преимущество не столь и заметно. Авторитетный в маковских кругах тестовый сайт Barefeats провёл свои исследования и постановил, что Стив глобально прав, хотя в реальности всё гораздо более сложно. Действительно, в некоторых ситуациях картина почти обратная и ПК обходит лучший из Маков.

Очень забавно. Видимо, руководитель фирмы должен был выйти на сцену и заявить, что сейчас он покажет, как машины конкурентов обставляют его собственные... Всё-таки надо повзрослеть и начать отличать рекламный дезодорант "Axe", от настоящего...

Другой авторитетный сайт, а именно знаменитый Think Secret протестировал тестовые Маки на базе камней х86, которые с понедельника продают разработчикам. Российский сайт Mikeosx опять же перевёл это в графику, за что ему отдельный респект. Понятное дело, кто побеждает здесь.

Ну и что мы увидели? Что и должны были увидеть. Сегодня лучшие G5 обходя по скорости х86 со свистом, что и показали в апреле. Именно по этой причине переход на архитектуру х86 начнётся только в 2006 году, и начнется он с ноутбуков и непрофессиональных машин. Именно там ситуация вообще критическая, так как G4 уже дышит на ладан, а обещанные обновления всё не идут. В этом сегменте Маки уже сейчас начинают отставать по мощности от ПК.

А вот профессиональная линейка перейдёт на х86 лишь в 2007 году, когда появятся совсем новые камни от Intel, которые "догонят и перегонят" IBM G5. А может ещё и IBM проснётся (см. мою предыдущую статью по этому поводу). Заодно и учтут опыт перехода первых машин, как "железный", так и софтверный.

И все-таки: почему Mactel?

Владимир Новиков aka VN_MAClover

Появилась новая информация, раскрывающая причины перехода Маков на процессоры от Intel. Её дали во время конференции разработчиков сотрудники Apple. Ясно, что это не вся правда, но всё же...

Итак, Freescale (бывшая Motorola) тихо уходит в процессоры для бытовой электроники и "умных домов". Планы "двухголовых" G4 всё откладывались и откладывались..., так что даже "переходные" ноутбуки на двухъядерных кристаллах выпустить практически невозможно. А не будем забывать, что Apple продаёт больше ноутбуков, чем настольных машин.

Отношения IBM и Apple были испорчены из-за ... Microsoft. Дело в том, что Sony, Nintendo и Microsoft стройными рядами пошли на поклон к IBM и решили установть ее новый процессор Cell на свои игровые приставки. Таким образом, IBM обязалась поставить в ближайшие три года 100 миллионов камней Cell с тактовой частотой 3.2 гигагерца. Разработчики Apple признались во время конференции, что протестировали Cell и выяснили, что с нормальными программами он работает хуже двухгигагерцного PowerPC. К сожалению, Apple в одночасье перестал интересовать IBM в качестве приоритетного партнёра, так как процессоры Cell не будут менять тактовую частоту все три года, а Apple требовал новые линейки хотя бы раз в полгода. Как известно, серверные камни от IBM тоже раз в год обновляются. В общем, имея такое маркетинговое покрытие от рынка игровых приставок, IBM просто похерил G5 и его версию для ноутов, в которой Apple позарез нуждается...

Что касается AMD, то значительную долю ее процессоров делает... IBM. Для Apple было просто опасно связываться с AMD, так как IBM мог обидеться... Кроме того, AMD просто не в состоянии так увеличить производство камней (и нынче-то у них напряги с поставками - А.Ф.). Наконец, уже сейчас известно, что ничто не помешает установить Mac OS X на компьютеры с камнями от AMD, так как именно эти камни стоят на машинах для внутреннего пользования Для сторонних же разработчиков раздают с Intel inside, контракт обязывает.

В общем, оставалось только пойти на поклон к Intel, благо те вот уже 25 лет зовут. Intel дал конкретные обещания не только поставлять камни, но и разработать нужные чипсеты, и так далее, что экономит для Apple миллионы долларов в год. Наконец, если и у Intel возникнут проблемы, то они будут у HP, Dell etc. - то есть у прямых конкурентов.

Ничего нового нет на белом свете. Опять деньги и конкурентная борьба, в которой не гнушаются даже кидаловом "в особо крупных размерах".

Ну и последняя новость для любителей хакинга, тюнинга и протчая. В пиринговых сетях уже лежит Mac OS X 10.4.1 for Intel, которая поставляется с машинами для разработчиков. По подчерпнутым мной, но непроверенным в связи с наличием нормального Мака сведениям, она прекрасно ставится на почти любой ПК, включая те, что с Савёловского, при условии наличия

контроллера SATA, к которому пристёгнут тот винчестер, на который система будет ставиться, DVD плеера, чипсета от Intel с встроенным видео либо одной из поставляемых Apple с Маками карт ATI (9000, 9200, 9600, 9650, 9700, 9800, X800). Сообщается, что пока встроенная графика от Intel работает лучше, а ATI - как повезёт, так как в мире ПК стопроцентно родных ATI карт мало.

Matrix: Reload, Revolution, RAID!

Евгений Патий, «Экспресс-Электроника», #12/2004

В числе основных инноваций, присутствующих в наборах системной логики i 915/925, отметим поддержку памяти DDR 2, шины PCI Express, новую архитектуру Socket 775, а также технологии High Definition Audio и Matrix Storage Technology, более известную как Matrix RAID. О последней технологии мы расскажем подробнее – в ближайшие годы она будет играть достаточно важную роль в нашей жизни.

Как ни странно, пресса почти не проявила интереса к одному из самых оригинальных технологических решений, использованному в последних чипсетах Intel. В этой статье мы попытаемся проанализировать новую технологию хранения данных, выявить ее преимущества и, естественно, недостатки, без которых не обходится ни одна новая платформа.

Сегодня в секторе настольных систем (а именно для них и предназначены наборы логики Intel 915/925) доминируют два традиционных метода хранения данных – RAID 0 и RAID 1. Технология Matrix RAID призвана не только дополнить их, но и разрешить извечный вопрос, с которым неизбежно сталкиваются пользователи при выборе метода хранения информации, – чему отдать предпочтение? Поставить во главу угла скорость обмена данными, постоянно чувствуя угрозу их потери в результате сбоя, или стабильность и безопасность зеркалирующего массива в ущерб скорости? Эта дилемма типична для IT -рынка в целом: скорость против стабильности.

В сущности, ситуация вовсе не безвыходная и имеются способы угодить всем, используя методы RAID 5 и RAID 0+1 ( RAID 10), обеспечивающие и скорость, и избыточность данных на случай непредвиденного сбоя. Оба подхода позволяют добиться высокой скорости обмена данными с помощью дисков, работающих не в режиме RAID, а также защиты от сбоя благодаря мгновенному бэкапу данных на резервный диск ( RAID 1, RAID 0+1). Необходимый результат можно получить, применив разряды четности, которые используются для восстановления информации, если на диске ( RAID 5) произошел сбой. Действительно, такие решения существуют, однако основной их недостаток – практически полная непригодность в составе массовых настольных решений, ведь цена, которую придется платить за скорость и безопасность, крайне высока (необходимо минимум три-четыре жестких диска и специализированный RAID -контроллер для объединения и управления всем этим дисковым хозяйством).

Хотя обычный пользователь просто не станет покупать больше двух жестких дисков, а уж если и купит – три-четыре жестких диска непросто разместить в корпусе настольного ПК, обеспечить им стабильное питание (мощный блок питания), охлаждение (один-два дополнительных вентилятора). Словом – кошка за мышку, мышка за репку – очень уж накладное и громоздкое получается решение.

Технология Intel Matrix RAID Storage призвана принести преимущества метода RAID 0+1 в массы. Алгоритмы Matrix RAID интегрированы непосредственно в чипсет, кроме того, для организации массива требуется лишь два жестких диска. Итак, на первый взгляд все выглядит великолепно: отдельный контроллер не нужен, поскольку «родной» уже имеется в микросхеме южного моста чипсета, жестких дисков необходимо всего два, а не три-четыре, как у стандартных уровней RA ID -массивов. Но, как известно, бесплатный сыр бывает только в мышеловке, поэтому нелишне выяснить, есть ли тут подвох, и если есть, то где он кроется.

Matrix RAID в теории

Принципы работы Matrix RAID достаточно просты. Напомним основы организации классических RAID -массивов: мы оперируем целыми жесткими дисками как таковыми. Из этих двух организуем RAID уровня 0, из тех тех-четырех – RAID уровня 5. Все операции по организации и управлению массивами реализуются на аппаратном уровне с помощью BIOS системной платы или выделенного RAID -контроллера — без вмешательства операционной системы.

Рис. 1. Архитектура Matrix RAID Matrix RAID позволяет осуществить более гибкий подход – при наличии в системе южного моста ICH 6 R и двух жестких дисков с интерфейсом SerialATA есть возможность разделить общее дисковое пространство на две части, причем объем каждой из них определяется пользователем. Одна часть функционирует как RAID уровня 0, другая – как RAID -массив уровня 1. Налицо и скорость, и возможность резервного копирования на случай сбоя. Для большего понимания механизма приведем пример: имеются два жестких диска объемом 200 Гбайт каждый. И первый, и второй диски разделяем на части объемом 50 Гбайт и 150 Гбайт.

Из томов объемом 150 Гбайт организуем скоростной массив уровня 0 с некритичными данными, из томов-пятидесятников – надежный, но неторопливый массив уровня 1.

Очень важно, что Matrix RAID, в отличие от привычных методов организации массивов хранения данных, не является программно-независимым. Скорее наоборот. Задействовать эту технологию удастся только под операционными системами Microsoft Windows 2000, XP, 2003, а также Linux, для чего имеется соответствующее обновление ядра 2.4. Если кому-то не хватает RAID -массивов под ОС Windows 95, 98 и M Е – беда невелика, а вот отсутствие поддержки Windows NT расстраивает по-настоящему.

Таким образом, Matrix RAID является, скорее, не аппаратной, а программно-аппаратной технологией. Причина тому — использование не только контроллера-концентратора ввода-вывода ICH 6 R, но и утилиты Intel Application Accelerator версии 4.х, являющейся на самом деле «сборной солянкой» из драйвера и управляющего ПО, с помощью которого и производится разбивка физических жестких дисков на тома, определение их ролей и т. д.

Организация такого «псевдо»- RAID массива при помощи Intel Application Accelerator выглядит несложно – пользователь создает первый том необходимого размера, определяя и его роль – то есть в каком режиме (0 или 1) он будет функционировать. Оставшееся свободное место выделяется под второй том, также с возможностью выбора режима функционирования. После завершения этих нехитрых процедур в системе появляется два жестких диска – на одном встроенном в южный мост контроллере и двух физических накопителях SerialATA мы получаем искомую скорость и стабильность. На данном этапе недостаток состоит в том, что размеры томов фиксированы – пользователь не имеет возможности впоследствии что-либо изменить, поэтому стоит заблаговременно определить необходимые размеры.

Как же обстоит дело с горячей заменой дисков, являющейся одним из несомненных преимуществ RAID -массивов? Применительно к Matrix RAID выходит, что один из дисков нельзя удалить «на ходу», не разрушив целостность данных.

Хотя полностью исключить возможность горячего подключения также нельзя – подобная возможность существует, но для третьего физического диска. Например, если подключить к Matrix RAID -массиву третий физический диск, то он вполне может быть задействован для репликации данных с RAID 1 в случае отказа какого-либо из соответствующих дисков. Кроме того, если после изъятия диска он не был подключен в течение десяти секунд, то автоматического определения вновь подключенного накопителя не происходит – необходимо сделать принудительное обнаружение новых устройств.

Как уже упоминалось, Intel поддерживает RAID -организацию только для двух дисков, несмотря на то, что южный мост ICH 6 R имеет четыре порта SerialATA 150/ RAID. Теоретически можно организовать два Matrix RAID -массива, но они будут независимыми друг относительно друга.

Компания Intel особо подчеркивает возможность апгрейда системы до Matrix RAID, для этого требуется к имеющемуся в системе SerialATA -винчестеру добавить второй. В принципе это понятно, однако приятно, что при организации массивов данные не теряются – Intel Application Accelerator способен выполнить необходимые действия в фоновом режиме.

Рис. 2. Области применения технологии Matrix RAID В заключение теоретической части определим достоинства и недостатки Matrix RAID.

К достоинствам следует отнести:

? наличие четырехпортового контроллера SATA RAID, подразумевающего возможность создания Matrix RAID -массива;

? RAID BIOS ROM – интегрированную в системный BIOS часть, отвечающую за создание, именование и удаление массивов;

? Intel RAID Migration Technology – технологию, позволяющую производить апгрейд подсистемы хранения данных до Matrix RAID ;

? интерфейс SerialATA AHCI с поддержкой NCQ и горячего подключения ( Advanced Host Controller Interface, присутствует только в Intel 915/925);

? полное программное управление массивами Matrix RAID.

Недостатков немного, но они все же есть. Отметим главный:

? отсутствие возможности динамического изменения объемов томов.

« И опыт, сын ошибок трудных»

В действительности реализация Matrix RAID не выглядит настолько уж простой, как может показаться на первый взгляд. Первым делом стоит воспользоваться BIOS системной платы, где находится программа низкоуровневого управления RAID -массивами, называющаяся Intel Application Accelerator RAID Option ROM. Перед разметкой массивов необходимо переключить режим работы контроллера SerialATA с IDE на RAID.

При корректном подключении SerialATA -дисков (по одному диску на порт SerialATA ), RAID Option ROM автоматически определяет наличие «почвы» для создания RAID -массива, причем, по желанию пользователя, это может быть как Matrix RAID, так и стандартный RAID. На данном этапе никаких проблем в принципе возникнуть не должно, интерфейс программы дает все необходимые сведения о процессе.

Рис. 3. IOMeter— Workstation, RAID 0 (2 диска), IOps

Рис. 4. IOMeter — максимальное время отклика, мс

Рис. 5. IOMeter — Database, RAID 0 (2 диска), IOps

Рис. 6. IOMeter — максимальное время отклика, мс

Рис. 7. IOMeter — File Server, RAID 0 (2 дискa), IOps

Рис. 8. IOMeter — максимальное время отклика, мс

Рис. 9. IOMeter — Database, RAID 1, IOps

Рис. 10. IOMeter — File Server, RAID 1, IOps Немаловажное обстоятельство: том Matrix RAID является загрузочным (как RAID 0, так и RAID 1), поэтому после разметки массива можно приступать к установке операционной системы. Но вот тут-то и начинаются проблемы. Несмотря на то что «новоиспеченный» Matrix RAID включает загрузочные тома и способен загрузить DOS, иногда инсталлировать Windows на один из томов не представляется возможным – инсталлятор ОС сообщает об удачно обнаруженном контроллере Intel 80801 ER без малейших признаков жестких дисков на нем. В таком случае панацеей от всех бед может стать обновление BIOS системной платы, если же и это не спасает - тогда от использования Matrix RAID стоит отказаться. Нужно помнить: установка Windows на систему с достаточно новым контроллером жестких дисков не всегда проходит гладко – ведь требуется обеспечить программу инсталляции драйверами контроллера от производителя, и вовсе не факт, что это сработает – устройство новое, драйверы, как водится, сырые, различных неувязок и несовместимостей может оказаться с избытком.

Кроме такого досадного обстоятельства существует еще множество подводных камней. Например, после установки тома RAID 0 с помощью Intel Application Accelerator и последующей перезагрузки может появиться ошибка чтения диска, обусловленная рассинхронизацией данных между дисками и программным обеспечением ( IAA в нашем случае) – данные приходят не в те моменты времени, когда ПО их ожидает. Как средство, Intel предлагает обновить IAA RAM Option ROM до более свежей версии, то есть обновить BIOS системной платы.

Не стоит забывать и о возможности подключения обычных IDE -дисков к портам SerialATA при помощи переходников – впрочем, точно поведение системы в этом случае предсказать довольно сложно. Правда, Intel не отрицает возможности такого подключения, но категорически не рекомендует его производить. Замечание, кстати, уместное для отечественного пользователя, стремящегося сэкономить в любых случаях. Так почему бы не подключить два старых IDE -винчестера по 20 Гбайт каждый через переходники и не сделать из них Matrix RAID ?

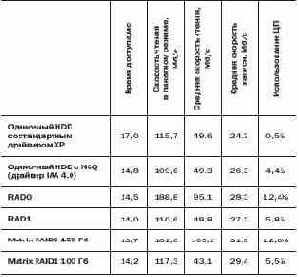

В заключение теоретических и практических изысканий хотелось бы привести результаты сравнительного тестирования, в котором участвовали «смешанный» Matrix RAID и «честный» RAID 0/1.

Тестовая платформа:

? процессор : Intel Pentium 4 ( Prescott ) 3,6 ГГц ;

? системная плата : ASUS P5AD2 Premium;

? оперативная память: Micron PC2-4300 (DDR2-533, 2x512 MB);

? жесткие диски: Western Digital WD1600JB (160 Гбайт, 7200 об/мин);

? операционная система : Windows XP Professional Service Pack 2.

Как видим, производительность «нулевой компоненты» Matrix RAID весьма высока. Более того, единственным решением, опережающим по скорости Matrix RAID 0, на сегодняшний день является RAID -массив из SCSI -дисков. Производительность массива Matrix RAID 1, хотя и не принципиальна, все же выше, чем у массива из IDE -дисков.

В любом случае решение Matrix RAID — практически единственный выход для пользователей, которые хотят добиться от своих дисков скорости и стабильности.И хотя сегодня технология выглядит «сырой», видимо, стоит подождать несколько месяцев до появления стабильных версий BIOS.

Забудьте о мегагерцах!

Евгений Патий, «Экспресс-Электроника», #11/2004

Сегодня уровень развития микропроцессоров самой распространенной из архитектур достиг той отметки, когда линейный рост тактовой частоты уже не приносит желаемого эффекта. Так, разницу между скоростью работы, к примеру текстового редактора, на процессорах с маркировкой 1200, 2200 или даже 3200 (причем не важно чего – мегагерц или рейтинговых единиц), увидеть просто невозможно. Но с другой стороны, существует целый ряд приложений, где производительности никогда не бывает много, а потому вопрос «как же ее повышать?» становится самым актуальным.

Первой данный факт признала компания Intel, кстати, негласно исповедовавшая принцип продажи мегагерц. Естественно, ею был сделан новый и, как водится, революционный ход стало — в процессорах для настольных систем компания внедрила технологию Hyper-Threading. Решение, надо признать, простое и элегантное: простаивающие ресурсы физического процессора (а это происходит всегда) отдаются «в подчинение» логическому чипу, который в результате оказывается «вторым».

Однако и здесь не все гладко. Смысл от внедрения нескольких процессоров — физических или логических — появляется лишь в том случае, когда операционная система, системные и прикладные программы «умеют» задействовать имеющиеся возможности. Хотя нужен ли второй процессор, если Windows 98 все равно работает с одним? И лишь Windows XP, более того, Windows XP с установленным Service Pack 2 уже способна адекватно работать с логическими процессорами. Подчеркнем — с логическими, то есть можно говорить о корректной поддержке технологии Hyper-Threading. Реально многопроцессорными конфигурациями операционные системы семейства Windows NT не удивишь уже давно, не говоря уже о различных *nix-клонах.

Впрочем, сегодня Hyper-Threading выглядит не так «свежо», как хотелось бы, ведь развитие полупроводникового производства открывает возможности для «усугубления» многопроцессорности на базе одного чипа – а именно полноценной многоядерности.

Как частный случай – двухъядерности. Повышенный интерес производителей процессоров к двухъядерному дизайну в немалой степени объясняется наличием такого мощного оружия, как изготовление чипов с применением технологических норм 90 нм. Уменьшение линейных размеров отдельно взятого полупроводникового элемента (естественно, транзистора) ведет к уменьшению линейных размеров всего чипа, позволяя выполнить инженерный маневр — допустим, разместить большее количество полупроводниковых элементов, формирующих, например, кэш-память второго уровня. А почему бы и не второе ядро?

В нашем случае многоядерность подразумевает, конечно же, всего два ядра, находящихся в пределах одного чипа – другими словами, это два раздельных процессора на одной кремниевой подложке. Преимущества такого подхода к проектированию высокопроизводительных процессоров очевидны, тем более что два сильнейших игрока на рынке серверных чипов уже выпустили подобные продукты – речь идет о Sun Microsystems и IBM. Если быть кратким, размещение двух процессоров в общем чипе — один из путей увеличения производительности без необходимости наращивания тактовых частот и «лишнего» энергопотребления. Иначе говоря, двухъядерный процессор, работающий с тактовой частотой ниже, чем у практически аналогичного одноядерного чипа, покажет более высокую производительность и потребует меньшее количество энергии. Хотя относительно последнего утверждения существуют вполне обоснованные подозрения, что прирост производительности будет наблюдаться исключительно для многопотоковых приложений.

Будущие многоядерные процессоры, уже тщательно проверенные в лабораториях, обеспечат симметричную мультипроцессорную обработку данных на одном кристалле. Так, пока одно ядро выполняет операцию, другое может извлекать данные из памяти или посылать команду операционной системе и т. п. При многопоточной обработке информации это приведет к гигантскому повышению производительности системы в целом. И если будущее вычислительной техники — за распределенной обработкой данных в неоднородных сетях, то многопоточная архитектура новых процессоров будет в большой степени соответствовать потребностям пользователей прикладного ПО.

Сегодня в Интернете сведения о новых двухъядерных чипах AMD крайне ограничены и зачастую противоречивы. Попытаемся создать образ будущего продукта, основываясь на имеющихся фактах, но никоим образом не претендуя на роль верховных судей. Как водится, в последний месяц перед официальным выходом процессора может измениться и дизайн, и спецификации, да и сами сроки.

У компании AMD есть сильный козырь — ввод в эксплуатацию предприятия Fab 36 в Дрездене (Германия), оснащенного оборудованием для выпуска чипов по технологическому процессу 65 нм. Специалисты компании полагают, что появление процессоров, изготовленных с применением данных норм не за горами — это 2006 год. Однако в 2005-м двухъядерные процессоры будут производиться с использованием технологии 90 нм. Если быть более точным, то 14 июля 2004-го года компания AMD объявила о завершении стадии разработки нового двухъядерного процессора. Процессор будет продаваться как Opteron для серверного рынка и Athlon 64 – для рынка настольных чипов. Конечно, речь не идет о практически одинаковых процессорах с разной маркировкой, они будут различаться частотой, объемом кэш-памяти и количеством выводов, имея лишь общую «начинку» — то, что называется dual-core. Существует три модификации двухъядерных Opteron – Egypt, Italy и Denmark, для «настольного» же двухъядерного Athlon 64 кодовое имя — Toledo.

Чип Athlon 64 Конечно, не стоит ожидать, что двухъядерные процессоры станут 32-разрядными. Архитектура IA32, как считают в AMD, доживает свой век, и новые чипы будут 64-разрядными, это даже не обсуждается.

Интегрированные в процессоры, спроектированные с учетом 64-разрядной архитектуры, контроллер памяти и шина Hyper Transport теоретически позволяют добиться от двухъядерного процессора производительности, аналогичной производительности двух раздельных процессоров, объединенных в рамках единой системы. Другое неоспоримое достоинство архитектуры AMD64 – своеобразное «предвидение» ситуации. Еще на стадии проектировании AMD64 разработчики предусмотрели возможность соединения до четырех процессоров Opteron, не используя набор системной логики, что позволяет без особых проблем объединить на одном кристалле кремния два процессорных ядра, так как все необходимые компоненты уже присутствуют.

По заявлению аналитика компании Mercury Research Дина МакКэррон, «чипы давно уже имеют многопроцессорный дизайн, просто изменилось физическое расположение ядер» — все, на первый взгляд, очень просто.

Немаловажное обстоятельство: в грядущих двухъядерных процессорах будет использоваться общий контроллер памяти. Он позволит избежать пресловутого «бутылочного горлышка» в конечной системе с точки зрения пропускной способности. Например, сегодняшний сервер на базе двух чипов AMD Opteron имеет, соответственно, два контроллера памяти, что обусловливает вполне достаточную пропускную способность: можно смело объединить два ядра, используя один общий контроллер.

Итак, двухъядерные процессоры будут совместимы с нынешними процессорными разъемами и, следовательно, с системными платами, отвечающими требованиям многоядерных процессоров. Потребуется обновление BIOS, но в целом новые чипы должны без проблем работать с платами сегодняшнего дня.

В отношении энергопотребления процессоров AMD собирается по-прежнему придерживаться своей нынешней тактики. Коль скоро имеются три градации энергопотребления — 30, 55 и 89 Вт, — есть все основания предполагать, что двухъядерные чипы будут им соответствовать.

Есть сведения, что двухъядерный процессор от AMD появится в форм-факторе Socket 939, будет изготавливаться по технологии «кремний-на-изоляторе» и 90-нм техпроцессу.

Точной информации о размерах ядер и количестве входящих в них транзисторов пока нет, однако можно сделать кое-какие предположения. Итак, площадь ядра ClawHammer с 1 Мбайт кэш-памяти второго уровня составляет 193 кв. мм. Для настольных систем данная площадь ядра выглядит великоватой, однако для серверных процессоров это не является проблемой.

Площадь собственно ядра ClawHammer составляет 28%, или 54 кв. мм, площадь 1 Мбайт кэш-памяти второго уровня – 42%, или 81 кв. мм, площадь блока северного моста и ввода-вывода – 30%, или 58 кв. мм.

Если мы предположим, что в двухъядерном процессоре у каждого ядра есть собственная кэш-память второго уровня объемом 1 Мбайт, то у нас будет: два ядра, два блока кэш-памяти и один общий блок северного моста и ввода-вывода, то есть без малого удвоенная площадь ядра ClawHammer.

С учетом перехода на более тонкий технологический процесс (90 нм против 130 нм) – площадь двух ядер составляет 33%, или 65 кв. мм, площадь двух блоков кэш-памяти – 49%, или 97 кв. мм, площадь блока северного моста и ввода-вывода – 18%, или 35 кв. мм. Итого, общая площадь двухъядерного процессора Opteron составит примерно 197 кв. мм.

Постараемся прояснить, каким же образом AMD удалось просто добавить еще одно процессорное ядро в чип, и обратимся к приведенной схеме.

Компания AMD не пошла по накатанному пути Intel, которая ранее просто использовала свободные ресурсы единого физического процессорного ядра для имитации логического второго процессора. Вместо этого реализовано второе физическое процессорное ядро с использованием шины Hyper Transport для межпроцессорных связей. На приведенной блок-схеме показано, каким образом компания AMD изначально предусмотрела потенциальную возможность установки на чип второго процессорного ядра. Основная идея состоит в том, что механизм, названный очередью системных запросов (System Request Queue, SRQ) может взаимодействовать с двумя процессорными ядрами «0» и «1». В нынешних чипах AMD присутствует только ядро «0», однако видно, что добавление второго ядра («1») требует минимальных усилий – вся необходимая инфраструктура присутствует с самого начала.

Одно из главных преимуществ двухъядерной архитектуры AMD перед технологией Intel Hyper-Threading — каждое процессорное ядро использует собственную кэш-память второго уровня. Не секрет, что одной из основных проблем при построении многопроцессорных и многоядерных систем является «борьба» за память. Если запущенное приложение достаточно мало и полностью помещается в кэш-памяти, то особых проблем не возникает, но сегодня время больших массивов данных. Работа с большими изображениями, обработка видеомассивов и баз данных означает интенсивное использование оперативной памяти. Именно поэтому столь существенная часть системы, как встроенный в процессоры Athlon 64 и Opteron собственный контроллер памяти, обусловливает взрывообразный рост производительности.

Борьба двух процессорных ядер за данные из основной памяти — факт отнюдь не новый. Такая же ситуация наблюдается и в более старых системах, оснащенных процессорами Xeon или Athlon MP (в таком случае ситуация далеко не радужна – в таких системах используется один двухканальный контроллер памяти для всех процессоров в системе). В подобных системах процессоры осуществляют запросы на доступ к основной памяти у контроллера памяти, находящегося, как правило, в северном мосту набора системной логики, и потому (в общем случае) прирост производительности с этой точки зрения составляет не более 50% по сравнению с однопроцессорной системой. Двухъядерная архитектура Athlon 64 и Opteron несколько больше, чем просто старая двухпроцессорная схема в рамках одного чипа.

Определенное преимущество размещения двух ядер (даже по старой двухпроцессорной схеме) на одном чипе – заметное уменьшение задержек, но маловероятно, что система с одним двухъядерным процессором Opteron будет показывать более высокую производительность, нежели система с двумя одноядерными Opteron. Последняя имеет два массива памяти, поэтому проблем с доступом к памяти, как у системы с двухъядерным Opteron, в данном случае не возникает.

На рынке присутствуют системные платы для двух процессоров Opteron, имеющие только один массив памяти, второй процессор получает доступ к памяти с помощью шины Hyper Transport. Конечные системы, собранные на основе данных плат, гораздо медленнее тех, что используют системные платы с раздельными для каждого процессора массивами памяти. Представляется, система на базе двухъядерного Opteron должна находится по производительности где-то между двумя вышеописанными случаями.

Стоит сказать несколько слов о шине Hyper Transport, которая будет применяться для межъядерных соединений в процессоре. Текущая версия Hyper Transport позволяет достичь пиковой скорости обмена данными 6,4 Гбайт/с (3,2 Гбайт/с в каждую сторону) на частоте 800 МГц — этого явно недостаточно для соединений между двумя процессорными ядрами одного чипа.

Видимо, для данного применения будет использоваться шина Hyper Transport с большей пропускной способностью.

Существует некая неопределенность относительно производства двухъядерных процессоров. Известно, что в любом случае, даже при использовании технологического процесса 90 нм, два процессорных ядра будут иметь большие линейные размеры, нежели единственное ядро, производящееся по техпроцессу 130 нм. Итого, на одну кремниевую пластину поместится меньше процессоров – ведь, по некоторым сведениям, AMD до сих пор использует кремниевые пластины диаметром 300 мм (это справедливо и для Fab 36 в Дрездене, «стартовый» техпроцесс которой – 65 нм).

Компания Intel также проявляет необычайную активность в данной области, вполне отдавая себе отчет, что «виртуальная двухъядерность», обусловленная технологией Hyper-Threading, никоим образом не может противостоять многоядерности реальной, невзирая на все свои преимущества. В мае текущего года Intel отменила планы по выпуску чипов, известных широкой общественности под кодовыми именами Tejas и Jayhawk, и предпочла заняться новыми двухъядерными продуктами для серверов и рабочих станций, чьи кодовые имена пока не обнародованы. Приблизительные сроки выпуска двухъядерных решений от Intel для серверов, рабочих станций и портативных компьютеров – 2005-й год.

Одной из перспективных задач, по мнению Intel, является переход от логического к физическому параллелизму. Как отмечает президент Intel Пол Отеллини, не стоит торопиться с выпуском "настольных" чипов с несколькими ядрами — компания будет следовать ранее намеченному плану. "В любом случае, - подчеркивает он, - наборы системной логики для десктопных многоядерных процессоров будут отличаться по своей архитектуре от чипсетов для обычных Pentium 4". Слухи о переводе Prescott на двухъядерное исполнение решительно отметаются представителями Intel. В самом деле, с точки зрения тепловыделения такой шаг равноценен безумию, ведь именно ради обратного эффекта было решено отказаться от выпуска Tejas.

Интересно, что президент Intel считает более перспективными именно процессоры с несколькими ядрами, а не чипы, поддерживающие 64-разрядные приложения, поскольку далеко не всегда 64-разрядность будет востребована, а переход на такие приложения продлится куда дольше, чем переход на ПО с поддержкой нескольких ядер.

В настоящее время вполне реальным является серверный чип с кодовым названием Montecito. И если на весеннем IDF ‘2004 в Калифорнии была показана кремниевая подложка с Montecito (двухъядерный Itanium), то к осени широкой общественности представили работающий прототип процессора, который должен пойти в серию в 2005 году. Помимо двухъядерности, Montecito будет обладать и многопоточностью, то есть операционная система будет видеть единственный процессор как четыре.

Чего стоит одно только количество транзисторов на кристалле Montecito — 1,72 млрд, которое объясняется в первую очередь поистине огромным объемом кэш-памяти третьего уровня — 24 Мбайт (по 12 Мбайт на каждое ядро). При этом задержки кэша третьего уровня останутся такими же, как и в нынешних процессорах Itanium 2. Объем кэш-памяти второго уровня у Montecito составит 1,25 Мбайт (256 кбайт — для данных, 1 Мбайт — инструкции), первого уровня — 64 кбайт (по 32 кбайт для данных и инструкций). Предусмотрены и так называемые буферы промахов, контролирующие работу кэш-памяти второго и третьего уровней.

Архитектура Montecito Как сказано выше, в каждом из ядер Montecito предполагается реализовать многопоточную обработку (по два потока в каждом ядре). На одном кристалле будет два ядра и, соответственно, четыре потока инструкций. Иными словами — четыре логических процессора, то есть в системах, аналогичных сегодняшним четырехпроцессорным на базе Itanium 2, получится 16 потоков инструкций, или 16 логических процессоров.

Ожидается, что производительность Montecito будет значительно выше, чем у нынешних Itanium 2 и тех, которые выйдут в ближайшее время. Это неудивительно — большой объем кэш-памяти и более высокая тактовая частота в сочетании с многоядерностью, многопоточной обработкой и более совершенной технологией изготовления должны сделать свое дело.

Список новаций, которые планируется реализовать в новом процессоре, пестрит хорошо известными кодовыми именами — Silvervale (серверный вариант технологии виртуализации, позволяющей процессору поддерживать на аппаратном уровне одновременную работу нескольких операционных систем), Pellston (повышение надежности кэш-памяти за счет отключения неисправных сегментов), Foxton (динамическое переключение тактовой частоты и рабочего напряжения в зависимости от вычислительной нагрузки). Схема арбитража в Montecito реализуется при помощи так называемого snoop-контроллера, отслеживающего выполнение инструкций в обоих ядрах. Еще один интересный механизм под названием Dynamic Thread Switching (динамическое переключение потоков) способен, как утверждают в Intel, фиксировать обработку операций, связанных с длительными задержками, и инициировать переход к обработке соседнего потока инструкций.

Montecito будет выпускаться по технологии 90 нм (при изготовлении нынешних Itanium 2 с ядром Madison используется техпроцесс 130 нм). В настоящее время двухъядерный Montecito, изготавливаемый с применением норм 90 нм, представлен в кремне начальным степпингом A0).

Если вам часто приходится заниматься

Если вам часто приходится заниматься обработкой музыкальных файлов и изменением формата видеофайлов, то многоядерность — это однозначно то, что вам нужно. Именно здесь работает формула 1+1 = 2. То есть добавление второго ядра может привести к повышению производительности до 90%. Во всех остальных случаях ситуация выглядит не столь радужно. Однако даже в офисном ПК на сегодня найдется не одна программа, желающая загрузить второе ядро. Хочется надеяться, что оптимизация популярных приложений не заставит себя ждать — и тогда новые (и не только новые) процессоры смогут полностью реализовать свой потенциал. Что касается самых больших консерваторов в этом деле — производителей игр, то уже в следующих версиях компании Epic (создатели Unreal) и Crytek (создатели Far Cry) полностью поменяют ядро физики.

Многоядерные процессоры: первые попытки

А.Н. Бондаренко.

Компьютеры+Программы

В программах, которые оптимизировались для использования Hyper-Threading, Pentium D 840 почти вдвое быстрее своих одноядерных предшественников.

Какими будут многоядерные процессоры будущего, нам пока не известно — но мы точно знаем, что основной тенденцией в развитии процессоров на ближайшее время будет именно многоядерность. И первые серийные образцы таких процессоров уже доступны (правда, пока только в составе готовых систем). И по ним уже можно сказать, что компания Intel движется в сторону многоядерности достаточно осторожно. Pentium Extreme Edition 840, уже протестированный нашими коллегами из IDG, являет собой фактически два отдельных процессора, объединенных в одной упаковке. Несмотря на кажущуюся простоту, при этом решались достаточно сложные задачи по скоординированному использованию процессорами FSB и реализации энергосберегающих технологий, использование которых зависит от внутреннего состояния обоих процессоров. Так что Pentium EE 840 можно рассматривать как первую попытку многоядерности, предназначенную для обкатки взаимодействия ядер на самом общем уровне.

С экономической точки зрения объединение двух независимых ядер в одной упаковке тоже вполне оправданно. Фактически пластину с выращенными ядрами процессоров можно разрезать и по одному ядру, и по парам. Режим работы уже готового процессора определяется коммутацией в упаковке. Так что, выпуская всего одно ядро, можно делать весь спектр процессоров — от одно- до многоядерных.

Однако такой подход может и не стать основным, поскольку имеет заметные недостатки. Прежде всего, это неоптимальное использование кэш-памяти. Этот изъян характерен и для обычных многопроцессорных систем. Независимые процессоры с большой вероятности кэшируют одни и те же данные, и при их модификации необходим механизм взаимного уведомления процессоров и актуализации их кэш-памяти.

Очевидно, что и с точки зрения максимизации размера кэш-памяти, и с точки зрения минимизации потерь времени на ее разделение, кэш-память должна быть общей для всех ядер. Однако собрать такой процессор из нескольких независимых заготовок невозможно. Тут необходима разработка абсолютно нового ядра — а это долго и дорого. Так что интрига даже в таком вроде бы частном вопросе будет сохранятся еще долго.

Пока же первая двуядерная платформа Intel включает, помимо "сдвоенного" процессора Pentium Extreme Edition 840 (обратите внимание, цифры "4" после Pentium нет), также набор микросхем Intel 955X Express. Pentium EE 840 имеет тактовую частоту 3,2 ГГц, частоту системной шины 800 МГц и 2 Мб кэш-памяти второго уровня (по 1 Мб на каждое ядро). Каждое ядро поддерживает Hyper-Threading, поэтому в системе видны четыре процессора.

Чуть позже (во второй половине года) должны начаться продажи процессоров Pentium D серии 8хх. Это будут Pentium D 840 (3,2 ГГц), 830 (3,0 ГГц) и 820 (2,8 ГГц), которые будут отличаться от Extreme Edition, в основном, отсутствием Hyper-Threading. Появится и более демократичный чипсет — Intel 945.

Производительность

Грустный факт: скоростной потенциал процессоров, как никогда прежде, стал зависеть от качества работы программистов. Грустно все это потому, что критерии оценки результатов труда разработчиков софта и железа слишком уж разные. Об оптимизации софта начинают думать уже после его коммерческого успеха. И никогда раньше успех массового ПО не зависел от его "распараллеливаемости". Не зря именно Intel взялась за разработку инструментария для написания "правильных" программ и оптимизации существующих.

Рисунок 1.

На сегодня же даже без тестирований можно сказать, что полностью готовы к использованию многоядерных процессоров, в общем-то, те же программы, которые и раньше неплохо использовали Hyper Threading. В основном, это программы обработки потоковых данных — аудио и видео.

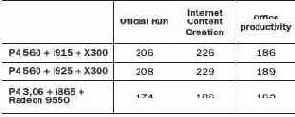

Таблица 1.

В нашем тесте Pentium Extreme Edition 840 работал на предсерийной материнке Intel D955XBK с чипсетом D955X и с двумя 512 Мб модулями памяти DDR2-667.

Сравнивалась эта система с Pentium 4 660 на материнке Intel D925XECV2 (чипсет i925XE) и с двумя 512 Мб модулями памяти DDR2-533 Corsair CM2X512.

Прочие параметры стендов: графика: MSI Geforce 6800 GT с 256 Мб памяти, драйвер Forceware66.77; HDD: Serial-ATA Maxtor Maxline III 250 Гб; ОС: Windows XP Professional SP2.

Результаты тестирования (кстати, весьма показательные) — в таблице ниже.

Таблица 2.

Игровые тесты тоже производились, однако ситуацию в играх достаточно хорошо иллюстрируют результаты 3D Mark 2003 CPU, также приведенные в таблице. Во всех играх Pentium Extreme Edition 840 уступает Pentium 4 660. В основном это "заслуга" создателей игр, которые пока не "параллелят" свои творения. Не исключено, что ситуация изменится — компания Intel уже довольно давно начала распространять новую платформу именно среди производителей игр.

В тесте Sysmark 2004 в дисциплине Office Productivity многоядерность не сыграла заметной роли. Другое дело — Internet Content Creation.Здесь уже присутствуют элементы обработки потоковых данных — а такие работы хорошо параллелятся. Adobe Photoshop, 3D Studio Max и Windows Media Player, использующиеся в этом подтесте, показывают до 30% прироста производительности.

Не менее хорошо заметен эффект от многоядерности в CineBench, который и раньше умел использовать все доступные процессоры, и в Spec CPU2000, который мы запускали в режиме "rate_base", позволяющем выполнять на каждом физическом и виртуальном ядре копию теста.

Nero Recode 2.2.6.9 от Ahead мы использовали, чтобы сжать фильм "Никита" с четырех до одного гигабайта. Это приложение многопоточное, поэтому эффект од многоядерности очень заметен.

Эффектный закат "гигагерц-ориентированной"

Сергей Антончук, "Комиздат"

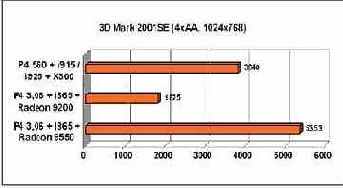

Последнее обновление в продуктовой линейке Intel, процессор Intel Pentium 4 Extreme Edition 3.46 ГГц с технологией HT, имеет практически ту же частоту ядра, что и предшественник, но более быструю FSB в 1066 МГц.

Совсем недавно IT-общественность была взбудоражена сообщением компании Intel о том, что производство чипов с частотой 4 ГГц пока откладывается, а основное внимание компании переносится на многоядерные процессоры и архитектуры систем. Комментариев по этому поводу было много. Хотя большая часть из них просто была связана с тем, что компания Intel кардинально начала ломать стереотип "скорость=частота". То, что повышение частот в мейнстрим-сегменте откладывается, совсем не означает, что откладывается выход более быстрых процессоров для обычных систем. Резервов повышения производительности пока более чем достаточно и без повышения частоты ядра процессора. И основной резерв - это, как ни странно, не технологический, а "идеологический" резерв. Современный ПК уже нельзя рассматривать как просто вычислительную платформу. Современный ПК - это центр обработки различных по своей природе и интенсивности информационных потоков, которые не всегда должны проходить через процессор или обрабатываться им.

Это стало заметно уже довольно давно, но только недавно архитектура массовых ПК стала строиться исходя из таких принципов. Массово появившиеся четыре месяца назад PCI Express платформы и стали началом этих изменений, причем настолько многочисленных и радикальных, что не все заметили главного :). ПК стал центром коммутации и обработки информационных потоков. И шина PCI Express создала прочный скелет для этой архитектуры, которая теперь может развиваться и наращивать свою производительность во многих направлениях.

И собственно появление нового процессора, Intel Pentium 4 Extreme Edition с эффективной частотой FSB 1066 МГц, - это в некоторой степени просто отражение изменений в околопроцессорной архитектуре, направленных на повышение общесистемной производительности. Именно здесь компания Intel видит большой резерв в повышении производительности системы в целом.

Pentium 4 EE 3,46 c FSB 1066, новый флагман процессоростроения, вышел в свет вместе с модернизированной платформой Intel 925XE Express, также поддерживающей новую частоту FSB. Изменение это было запланированным. О нем компания заявляла еще при появлении семейства LGA775 процессоров и чипсетов i915/i925.

P4ee

Технические характеристики процессора Intel Pentium 4 3,46 EE

Сокет - LGA775

Тактовая частота, МГц - 3460

Front Side Bus, МГц - 266

L1-Cache, Кб - 8

L2-Cache, Кб - 512

L3-Cache, Кб - 2048

Наборы инструкций - MMX, SSE, SSE2

64-битные расширения - Отсутствуют

Hyper-Threading - Присутствует

Максимальная потребляемая мощность, Вт - 110,7

В новой связке "процессор-чипсет-память" частоты элементов и шин, их соединяющих, являются наиболее согласованными. Эффективная частота FSB - 1066 МГц, то есть ее физическая частота составляет 266 МГц (процессорная шина Pentium 4 является Quad Pumped, то есть передает четыре бита информации на каждый такт синхронизации). Такую же частоту имеет интерфейс памяти DDR2-533. Таким образом, физические частоты соотносятся как 1:1, а эффективные - как 2:1. Для всех остальных систем, использующих память DDR2-533, эти соотношения дробные, то есть они работают в асинхронном режиме, который неизбежно ведет к потерям производительности. Поэтому степень повышения пропускной способности памяти в новой системе превышает просто соотношение частот FSB - 1066 к 800, оно несколько больше.

Кроме синхронного режима работы, новый процессор имеет еще несколько преимуществ. Прежде всего это:

* Встроенный в процессор кэш L3 объемом 2 Мб, обеспечивающий быстрый доступ к большим объемам часто используемых данных. Его использование позволяет сократить среднее время доступа к основной памяти и повысить ее пропускную способность.

* Advanced Transfer Cache L2 объемом 512 Кб - работающий на частоте ядра процессора 256-разрядный кэш с развитым механизмом предварительной выборки данных.

Enhanced floating-point/multimedia unit. Регистры для работы с вещественными числами расширены до 128 бит, и добавлен дополнительный регистр для пересылки вещественных данных. Это позволяет повысить производительность и в вычислительных, и в мультимедийных задачах.

* Rapid Execution Engine. Четыре целочисленных АЛУ работают на удвоенной частоте ядра процессора, что позволяет увеличить вычислительную пропускную способность и снизить время выполнения некоторых целочисленных операций.

* Execution Trace Cache.

Модернизированный кэш инструкций L1 убирает задержки в при считывании декодированных инструкций. Это позволяет значительно повысить эффективность работы кэша по сравнению с кешированием самих инструкций. Данный подход позволяет значительно поднять производительность подсистемы памяти при выполнении повторяющихся фрагментов программного кода. * Advanced Dynamic Execution. Механизм улучшенного предсказания ветвлений позволяет повысить производительность для всех типов приложений путем оптимизации последовательностей выполняемых команд. * Расширены и возможности чипсета. Чипсет Intel 925XE теперь поддерживает работу с более быстрой памятью DDR2 533 CL3. Основная ее особенность - меньшая латентность доступа. Именно большое время доступа многие раньше считали основным недостатком памяти DDR2 533. Следует также отметить, что память типа DDR2 400 этим чипсетом не поддерживается. Эффективность изменений Естественно, нас заинтересовал практический эффект от модернизации основных скоростных характеристик "околопроцессорной" части архитектуры. Поэтому мы провели сравнение двух примерно равных по частоте и по архитектуре процессоров Pentium 4 EE 3,4 ГГц (FSB 800 МГц) и Pentium 4 EE 3,46 ГГц (FSB 1066 МГц). Платформа была одна - это материнка Intel Desktop Board D925XECV2, 1Гб памяти DDR2 533, видеокарта ATI X800XT, винчестер Maxtor MaXLine III 250Гб. Так что разницу в результатах можно смело относить именно на изменение скорости FSB. Результаты тестов и оценка прироста приведены в таблице. Как мы видим, прирост производительности составляет от 2 до 8% в зависимости от используемых приложений. Это только эффект от повышения частоты FSB. Что осталось у нас незадействованным, так это использование памяти DDR2 533 CL3. Как только она появится, мы проанализируем эффект и от нее. В ближайшей перспективе следует также ожидать поддержки памяти DDR2 667, стандарт на которую утвержден и которая уже появляется на рынке. По заявлению некоторых производителей материнских плат, им не нужно будет делать никакого редизайна существующих плат для поддержки этой памяти.

Правда, в этом случае и для FSB 800, и для FSB 1066 система будет работать в асинхронном режиме. В несколько отдаленном будущем следующей "красивой" комбинацией станет DDR2-800 и FSB 800. Это действительно будет интересно, все соотношения будут 1:1. Так что и без повышения частот процессоров скучать не придется.

Что было раньше?

Во-первых, напомним, что шина PCI, бывшая буквально до последнего времени безусловным стандартом, не так давно отметила десятилетний юбилей - а это, согласитесь, в компьютерном летоисчислении аналогично отрезку времени от египетских пирамид до наших дней. Еще в далеком 1991 году компания Intel представила первую спецификацию системной шины, известной как Peripheral Component Interconnect, которая в сжатые сроки вытеснила устаревшую даже по тем временам шину ISA, верой и правдой прослужившую очень долго, а также ее более дорогую и менее удачную серверную сестру EISA.

Что можно сказать о шине PCI? Во-первых, пропускная способность PCI была гораздо выше пропускной способности ISA. Во-вторых, важнейшее различие этих двух интерфейсов - возможность динамического конфигурирования периферийных устройств, подключенных к PCI, то есть система распределяет ресурсы между периферийными устройствами наиболее приемлемым в данный момент времени образом и без постороннего вмешательства.

Итак, начало положено. Вряд ли кто-то из разработчиков тогда думал о том, какая долгая жизнь уготована интерфейсу PCI (мы говорим не конкретно о версии 1.0, а о Peripheral Component Interconnect вообще). Однако толчком к бурному росту числа продуктов, ориентированных на использование с шиной PCI, стало появление двумя годами позднее второй редакции стандарта PCI, 2.0 - и с этого момента началось медленное, но уверенное «выдавливание» с арены ветеранов ISA и EISA.

До сих пор все прекрасно помнят основные параметры PCI 2.0 - это, конечно, ширина шины, равная 32 битам, максимальное адресуемое адресное пространство 4 Гбайт, тактовая частота шины 33 МГц при синхронном обмене данными и пиковая пропускная способность 133 Мбайт/с. И напоследок: устройства были рассчитаны на напряжение питания 5 В и 3,3 В. По сегодняшним меркам - смехотворные цифры. Но в 1993 году такие величины казались поистине громадными.

Со временем появилось множество вариаций на тему PCI 2.0, наиболее распространенные из которых - стандарт PCI 2.2, стандарт AGP, PCI-X, mini-PCI и Card Bus (32-разрядная версия стандарта PCMCIA, допускающая горячее подключение).

Каковы основные шаги в развитии PCI с точки зрения вышеупомянутых вариаций? Наиболее заметна для конечного пользователя была, естественно, шина AGP, являющаяся, тем не менее, частным случаем PCI 2.0.

AGP предназначена для использования с производительными графическими адаптерами, которым недостаточно даже пиковых скоростных значений PCI 2.0. AGP характеризуется отсутствием арбитража интерфейса - допускается подключение к этой шине только одного устройства; хотя, версия AGP 3.0 нивелирует это ограничение, к ней можно подключить уже два устройства (при наличии, разумеется, двух соответствующих разъемов на системной плате). Шина AGP появилась в четырех вариациях, которые различаются между собой пиковой пропускной способностью - AGP 1x, 2x, 4x и 8x. Несмотря на то что скоростей четыре, стандартов AGP три - AGP 1.0, 2.0 и 3.0. Кроме того имеется спецификация на питание шины AGP Pro. Не менее ярко выступил стандарт PCI 2.2, в котором ширина шины может быть увеличена до 64 бит, а также допускается «разгон» тактовой частоты до 66 МГц - вдвое по сравнению с PCI 2.0. Еще дальше пошла PCI-X - это ни что иное, как ускоренная до 133 МГц шина PCI 2.2 с обязательно 64-битной разрядностью интерфейса. PCI-X выпускалась и в более форсированных вариантах, с 266 МГц и 533 МГц тактовой частотой. Менее заметна, но не менее важна шина mini-PCI, применяющаяся в портативных компьютерах для подключения различной «мелкой» периферии. Из вышесказанного следует, что удачная разработка PCI развивалась отнюдь не линейно - встречались и ветвления для узкоспециализированных применений: AGP - графика, PCI 2.2 - периферийные потребительские устройства, PCI-X - серверная периферия, mini-PCI и Card Bus - нашли место в ноутбуках. Пиком скоростного развития стандарта PCI можно назвать PCI-X 533 и AGP 8x. А дальше - общеизвестная история: основные компоненты вычислительных систем, процессоры и память выросли из детских штанишек межкомпонентного интерфейса, что, в принципе, не так уж и страшно. Беда в том, что далее наращивать пропускную способность PCI оказалась технологически сложно и дорого. Например, для того чтобы не мудрствуя лукаво наращивать тактовую частоту, требуются дополнительные проверки для исключения сбоев - новая разводка, новые сигналы, что в конечном итоге отражается на стоимости решения.Требуется совершенно новая разработка, гарантирующая «безболезненную» масштабируемость и наращиваемость на ближайшие несколько лет.

Что впереди?

На сегодняшний день четко очерчены границы применения шины PCI Express. В привычных настольных компьютерах этот стандарт должен упразднить лишь шины PCI и AGP, грубо говоря, «PCI и компанию». Нет оснований полагать, что PCI Express станет связующим звеном для дисковой подсистемы, подсистем памяти и процессора, его удел - периферия. Более широкий круг задач - на рынке портативных систем; помимо подключения внутренних периферийных устройств PCI Express будет применяться для связи с док-станциями ноутбуков и внешними периферийными картами, которые придут на смену сегодняшним PC Card.

Производительные рабочие станции и серверы смогут задействовать PCI Express и для подключения дисковых массивов. В целом, судя по спецификациям, будущее этого интерфейса достаточно безоблачно: особую надежду вселяют значения пропускной способности 2,5 Гбит/с на канал, определенные в качестве стартовых - значит, есть куда расти. Небольшая ложка дегтя, выраженная в необходимости отдать 20% трафика по шине на служебные нужды, не может служить весомым поводом для беспокойства. Ведь по большому счету, если переживать из-за всех уступок человека железу, можно впасть в состояние перманентной депрессии. А если вспомнить о восторгах со стороны многочисленных производителей периферийного оборудования по поводу PCI Express, тем более, можно жить и радоваться. Но вернемся к названию статьи: утопия ли PCI Express? Нет, это вполне сбалансированное и своевременное решение. PCI Express - попытка общей стандартизации? Тоже нет, ведь всех под одну гребенку все равно не причесать. Чем же тогда все-таки является PCI Express? Пожалуй, требованием времени.

PCI Express, в девичестве «Arapahoe»

О грядущем тупике разработчики, конечно же, догадались отнюдь не вчера. Еще в пору ожидания AGP 3.0 в Интернете вовсю ходили слухи о новом межкомпонентном интерфейсе, разрабатываемом в недрах Intel под кодовым названием Arapahoe, сейчас 3GIO (Third Generation In-Out - ввод/вывод третьего поколения). Главным отличием этого решения должен был стать последовательный интерфейс. Это означало, во-первых, однозначное подключение «точка-точка», исключающее арбитраж шины и перетасовку ресурсов (как частный случай: прерываний). Во-вторых, упрощалась схемотехника, разводка и монтаж. В-третьих, экономилось место. Огромный плюс - отпадает необходимость в громоздкой синхронизации сигналов. Ведь при параллельной организации передачи все происходит на «делай раз, делай два», биты приходят от источника к приемнику не вразнобой, а «строем». Кстати, с увеличением таковых частот синхронизация добавляла разработчикам немало головной боли. На самом деле преимуществ последовательных интерфейсов перед параллельными гораздо больше, но они относятся, в основном, уже к «дебрям».

Итак, новая последовательная шина, которой предписывалось решить все проблемы компьютерной отрасли разом, получила название PCI Express - это случилось 22 июля 2002 года. Основной двигатель прогресса здесь, конечно же, корпорация Intel. Более того, существует весьма любопытный факт - несмотря на то что компания AMD делала большие ставки на свою шину Hyper-Transport, даже ее Intel удалось склонить на сторону продвижения PCI Express. Это обстоятельство стало буквально козырной картой интерфейса, и теперь IT-общественность не сомневается: PCI Express - быть. Давайте разберемся, чему собственно быть.

Во-первых, новая шина теоретически должна выступить в качестве основного транспорта между всеми, без исключения, узлами компьютера. В самом деле, ведь предшественница PCI ввиду своего отставания от требований к пропускной способности с течением времени оказалась постепенно вытесненной из основного «круговорота»; и выглядела уже не как первостепенной важности элемент, а, если хотите, как обуза.

Процессор с памятью, диски Serial ATA, даже сетевые контроллеры - все компоненты обходились своими собственными соединениями. Что же оставалось PCI? Диски Parallel ATA, модемы, сетевые да звуковые карты. Согласитесь, не совсем достойная участь для некогда революционной разработки. В общем, при разработке спецификаций нового стандарта Intel не стала изобретать ничего кардинально нового - в ход пошли передовые наработки из сетевой отрасли. Много внимания инженеры уделили и кодированию информации с устойчивостью к ошибкам. Опираясь на два этих факта, можно сказать, что PCI Express - это очень современно. Также стоит вспомнить, что подобный подход уже однажды был применен Intel на этапе внедрения процессора Pentium 4: как необычно звучало словосочетание Intel Hub несколько лет назад… PCI Express - последовательный интерфейс, имеющий много общего с сетевой организацией обмена данными. Сетевые термины, наподобие Hub, уже прочно вошли в лексикон не только системных администраторов, но и схемотехников: в современных платформах основной связующий компонент системной платы носит название Root Complex Hub, который выглядит как перекресток трех шин - процессорной, шины памяти и PCI Express. На данном этапе Root Complex представляется как некий альтернативный узел, снабженный одним или несколькими портами PCI Express. Для взаимодействия с остальными узлами ПК, которые так или иначе обходятся собственными шинами (это не обязательно процессорная шина и шина памяти, некоторое время неизбежно присутствие и старинных PCI 2.2 или PCI-X) предусмотрена система мостов и свитчей. Логика всей структуры такова, что любые межкомпонентные соединения непременно оказываются построенными по принципу «точка-точка», тем более, ни о какой широковещательности речь не идет, вышеупомянутые свитчи-коммутаторы выполняют однозначную маршрутизацию пакета от отправителя к получателю. Коммутаторы могут выполнять и более интеллектуальные функции, нежели простой роутинг данных. Имея последовательно-сетевую природу, стек PCI Express разделен на три уровня: аппаратный (Physical - физический), аппаратно-логический (Data link - передача данных) и логический (Transaction - транзакции).

Начнем с аппаратного - здесь есть как новинки, так и аксиомы принципов передачи информации. Уже не раз говорилось, что стандарт PCI Express «исповедует» последовательную передачу данных. На аппаратном уровне реализовано разностное усиление сигнала (сигнальный уровень PCI Express составляет 0,8 В): по одному проводнику передается положительное аналоговое представление сигнала, по второму - отрицательное. Разностный приемник сигнала на другом конце линии инвертирует принятый сигнал и складывает с сигналом, прибывшим по другому проводнику, поэтому, если где-либо сигнал был «разбавлен» помехой (которая подвергла воздействию оба проводника), то она сама себя нивелирует. PCI Express построен на принципах симплексной технологии, а это означает, что сигналы идут одновременно, в противоположных направлениях и по отдельным парам проводов - итого две пары, называемые линией. Стандарт декларирует пропускную способность симплексной линии на отметке 2,5 Гбит/с в одну сторону или, соответственно, 5 Гбит/с в обе стороны. Однако эти значения масштабируемы. Как всегда, и применительно к PCI Express не обошлось без компромиссов и обходных путей. Указанные значения пропускной способности являются идеальными - то есть в реальной жизни они, к сожалению, не достигаемы. Из-за традиционных технологических неувязок разработчики отказались от применения отдельной линии для синхросигналов, поэтому пришлось идти в обход - урезать длину последовательности нулей и единиц, которые могут вызвать проблемы с синхронизацией. Приемник воспримет входящий сигнал как постоянный ток, не различая начала и конца любой последовательности данных - впору даже лампочку подключать. Пришлось сделать «новый байт для PCI Express», состоящий из десяти бит, которые уже можно отделить друг от друга. Восемь бит - хрестоматийные, два бита - служебные. В итоге - 20%-ную избыточность, а значит, 20% от заявленных 2,5 Гбит/с и 5 Гбит/с мы так и не увидим. То есть синхронизация все-таки имеется, но выполнена она таким оригинальным образом.

Что же случится, если по шине не проходит никаких данных? Велика возможность рассогласования между отправителем и адресатом, поэтому трафик на шине PCI Express не прекращается никогда: в отсутствие данных посылаются специальные последовательности из нулей, закодированные по все той же десятибитной схеме. При инициализации линии, связывающей две точки (отправителя и адресата), происходит пересылка специальных начальных последовательностей. В этих последовательностях могут быть закодированы параметры соединения. Во время сеанса связи могут возникнуть и такие неприятности, как несоответствие работы тактовых генераторов передающей и приемной стороны. Для того чтобы поправить положение, периодически в потоке данных передаются специальные корректирующие последовательности. Степень необходимости внедрения корректирующих последовательностей определяется исходя из разницы между показателями тактовых генераторов. В любом случае дополнительные кодирующие последовательности, как и необходимость внедрения избыточности с целью синхронизации, негативно сказываются на производительности, так как неизбежно влекут за собой временные потери. Для организации связи в реальном времени такой путь не подходит, поэтому разработчикам таких критичных к латентности систем придется изобретать собственные протоколы обмена. Можно сказать, что на данном этапе последовательная передача, как таковая, заканчивается. Единственное соединение, представляющее собой линию PCI Express, две пары проводов, - этого не достаточно для обеспечения высокой пропускной способности. Поэтому линии привычно выстраивают в ряд - их может быть 32, 16, 12, 8, 4 и 2. В итоге, вся последовательность данных, которую необходимо передать, распределяется на все имеющиеся линии «веером»- передача параллельная, но не синхронная. Если имеется 12 линий, то первый байт блока данных передается по первой линии, второй - по второй, и т. д., а тринадцатый байт - снова по первой. Теоретически шина с 32 линиями способна выдать пропускную способность 20 Гбит/с, от которых отнимаем 20% - 16 Гбит/c, или же по 8 Гбит/с в каждую сторону. Более высокий уровень стека PCI Express отвечает за корректность передачи данных.

Получив от самого верхнего уровня иерархии, Transaction, для передачи пакет данных, алгоритм Data Link присоединяет к последнему номер последовательности и его контрольную сумму. Кроме того, Data Link отвечает и за информирование остальных уровней стека о состоянии канала связи. Третья важная функция Data Link - управление энергопотреблением. Наиболее интеллектуальный уровень PCI Express - Transaction Layer, который задействует четыре различных адресных пространства. Это память (адрес может быть как 32-, так 64-разрядным), сообщения, конфигурация и ввод/вывод. Интересно организовано управление функциями питания PCI Express. Конечно, новый стандарт базируется на основных принципах управления питанием своего предшественника PCI и отвечает требованиям ACPI 2.0 и PCI Bus Power Management Interface Specification 1.1. Для каждого соединения управление питанием выполняется индивидуально, а регламент предусматривает привычные четыре состояния - L3, L2, L1 и L0s. Состояние L3 соответствует режиму «выключено», L2 - отключение основного питания и частотного генератора, L1 - формальный режим совместимости с PCI, при котором уровни питания и частоты находятся в номинальном режиме, но степень готовности ниже, чем в полностью «заряженном» режиме L0s. В последнем для восстановления состояния канала связи не требуется выполнять повторную инициализацию соединения, достаточно лишь «взбодрить» линию быстрой последовательностью тренировки канала. Кроме соответствия традиционным требованиям энергосбережения, стандарт PCI Express обладает и эксклюзивными механизмами управления питания - это ASPM, Active State Power Management. ASPM обладает завидной автономностью и способен переводить устройство в оптимальный режим работы без инструкций свыше (со стороны ПО). Это не означает, что устройство, давно не подававшее признаков активности, будет полностью отключено, но переведено в режим пониженного потребления L0s - наверняка. Стандарт PCI Express считает устройство неактивным, если за время, равное 7 мкс, с ним не было никакого обмена данными.Как только возникает потребность в обмене, устройство возвращается в рабочее состояние. Напомню, у различных устройств может быть абсолютно разное время «засыпания» и «пробуждения», поэтому эти параметры сообщаются Active State Power Management на этапе конфигурирования.

Шина PCI Express: утопия или общая стандартизация?

Евгений Патий

"Экспресс-электроника", #01-02/2005

Развитие компьютерной индустрии можно изобразить в виде кривой, чем-то напоминающей электрокардиограмму: более-менее стабильные периоды сменяются экстремумами. При этом данное утверждение можно отнести как к уровню продаж, так и к технологическим достижениям. И хотя в последнем случае все не так однозначно, ведь очередному пику предшествует кропотливая исследовательская работа, тем не менее, взаимосвязь рыночных скачков и провалов с технологическими зачастую носит прямо пропорциональный характер.

Аналогична и ситуация с системными шинами для персональных компьютеров, построенных на базе архитектуры x86. Прежде чем приступить к предметному разговору, стоит провести небольшой исторический экскурс, чтобы выделить логическую необходимость новых технологических решений.

Воплощение

Аппаратная реализация слотов PCI Express чем-то напоминает матрешку. Имеются четыре разновидности контактных наборов на 1, 4, 8 и 16 линий соответственно. Периферийные карты с меньшим количеством контактов можно устанавливать в слоты с большим количеством контактов, при этом будет задействовано именно столько линий, сколько разведено на карте.

Если в 16-канальный слот установить 16-канальную PCI Express-видеокарту, это будет оправданное решение, пропускной способности в данном случае не бывает много. Но если в такой же слот установить, скажем, модем 56K, не заполняющий и один канал шины, - это уже вопиющая расточительность.